jdk 버전 : jdk-8u321-linux-x64

스파크 버전 : spark-3.2.1-bin-hadoop3.2

설정 파일 : spark-env.sh

위치 : spark-env.sh 파일은 보통 스파크 설치 파일의 conf 폴더 안에 있다.

예를 들어서 내가 /home 에 스파크를 설치했으면

/home/spark/conf/spark-env.sh 가 있을 것이다

export SPARK_WORKER_CORES=4

export SPARK_WORKER_MEMORY=8g

위와 같이 설정하면 워커당 4개의 코어와 8기가의 메모리를 갖는다.

export SPARK_WORKER_CORES=3

export SPARK_WORKER_MEMORY=6g

위와 같이 설정하면 워커당 3개의 코어와 6기가의 메모리를 갖는다.

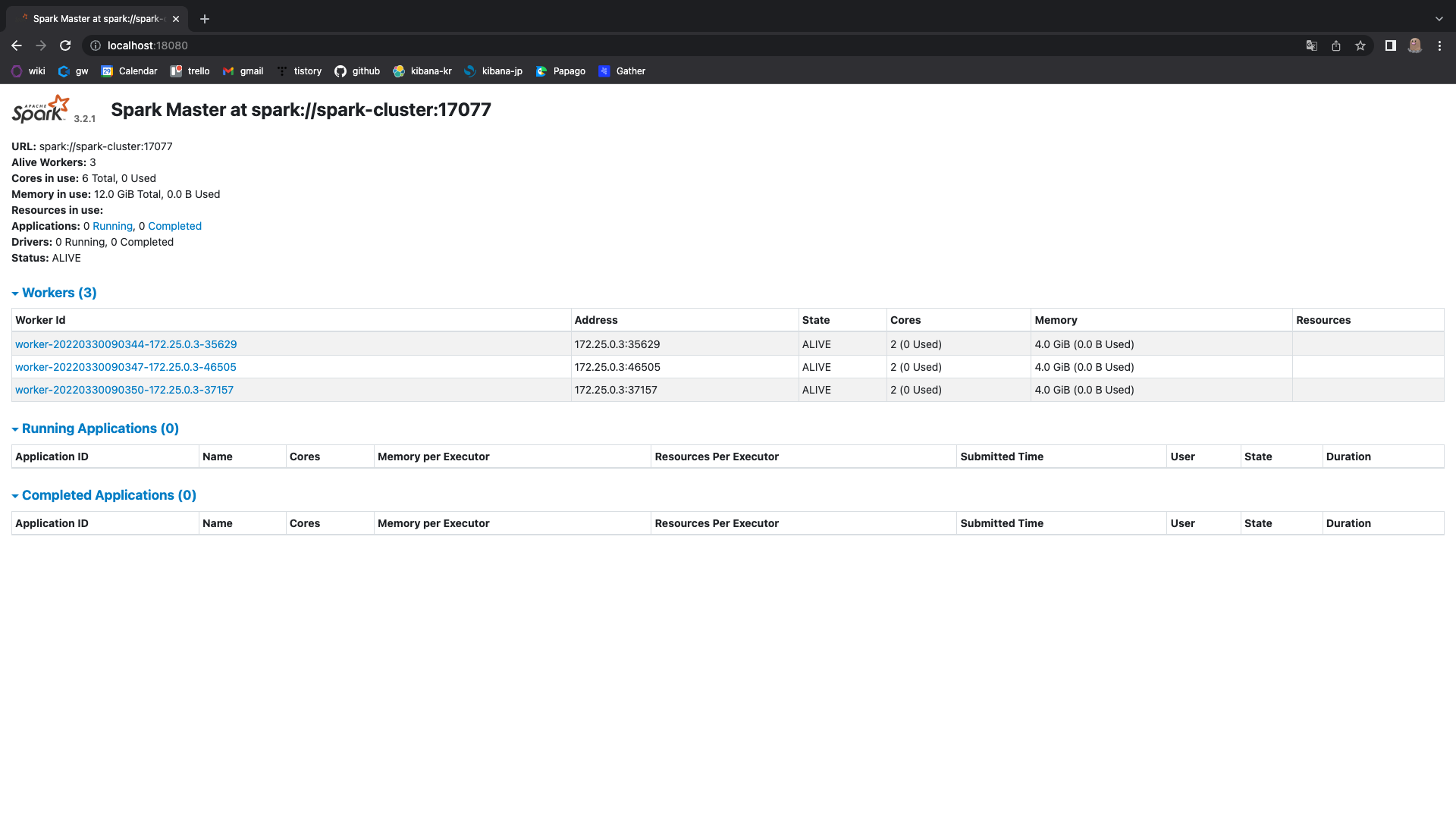

export SPARK_WORKER_CORES=2

export SPARK_WORKER_MEMORY=4g

위와 같이 설정하면 워커당 2개의 코어와 4기가의 메모리를 갖는다.

'Data Engineering > Spark' 카테고리의 다른 글

| [Spark] Apache Spark Stand-Alone 실행, 종료하는 방법 (0) | 2022.03.30 |

|---|---|

| [Spark] 스파크 메인 웹 UI (스파크 마스터) 포트 변경하는 방법 (0) | 2022.03.30 |

| [Spark] 스파크 스탠드얼론 워커 갯수 설정하는 방법 (stand-alone) (0) | 2022.03.30 |

| [Hadoop] 하둡 core-site.xml 설정파일 확인하기 (0) | 2022.03.25 |

| [Spark] 스파크 실행시 설정값 우선순위 (0) | 2022.03.25 |