스파크와 제플린을 실행시킨다.

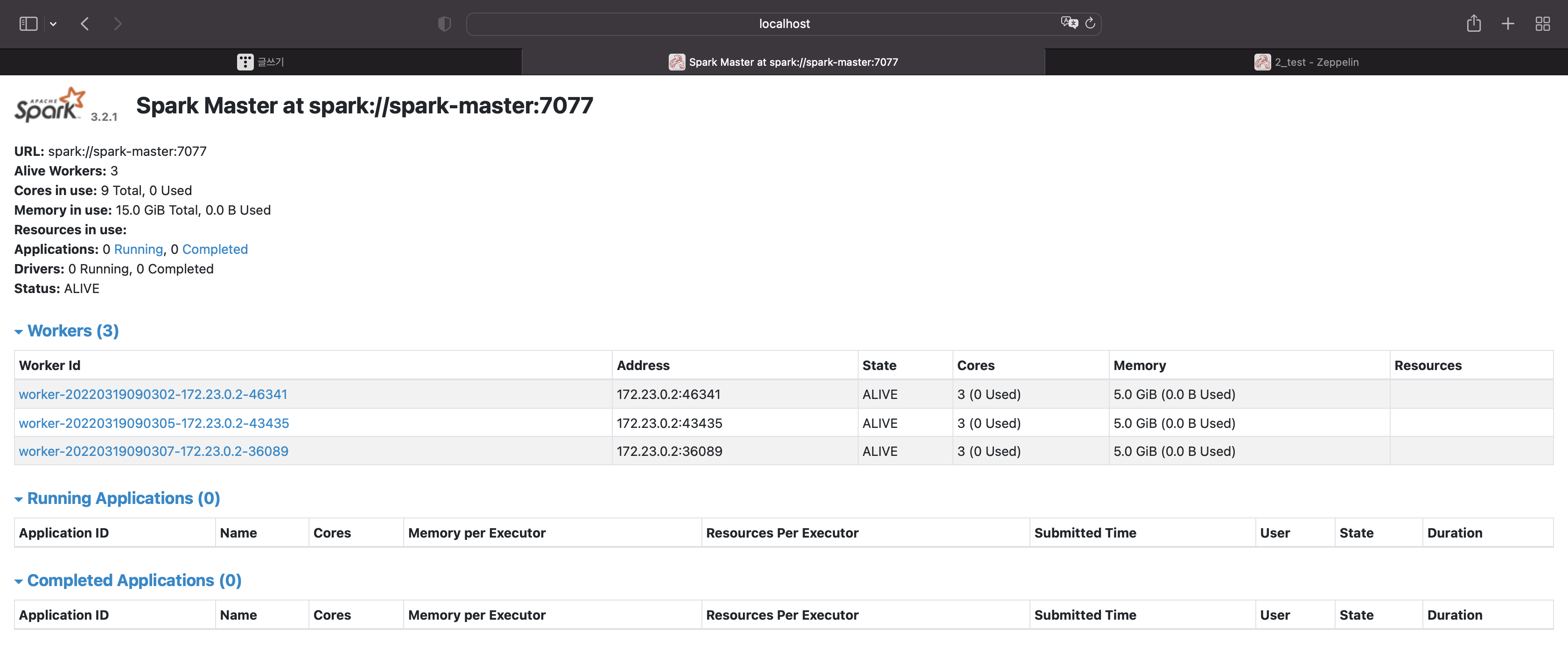

스파크 ui

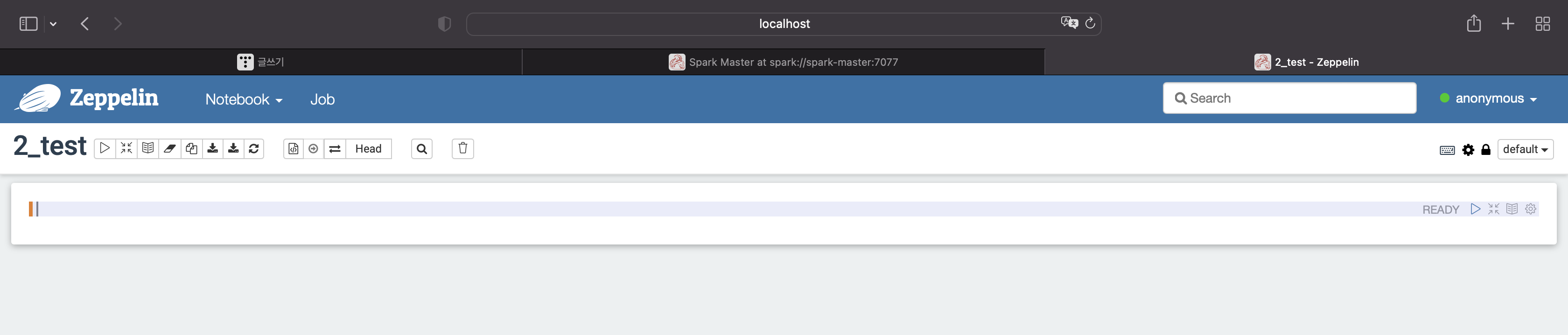

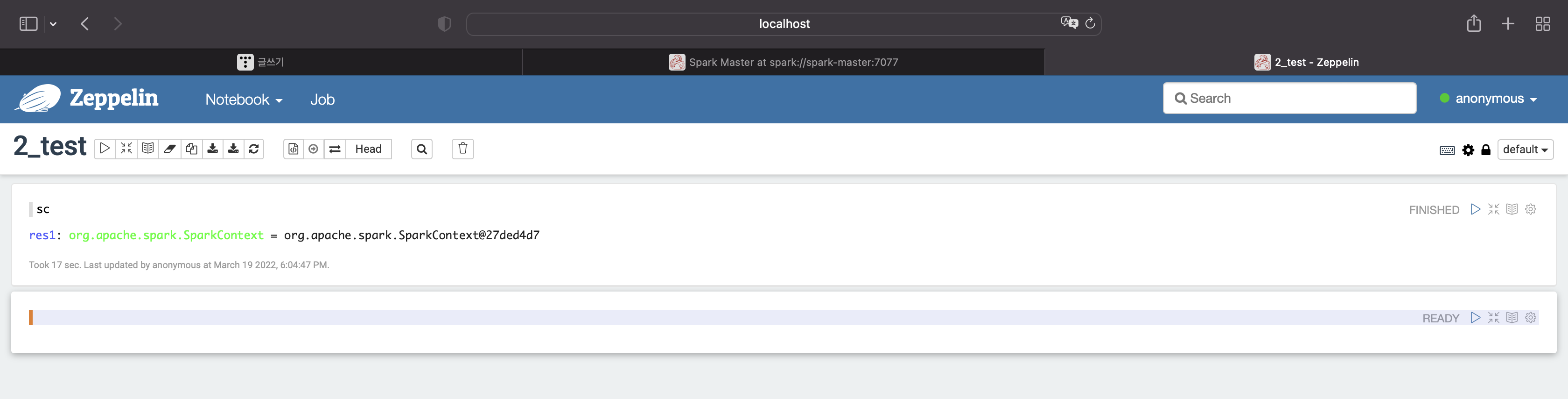

제플린

다음과 같이 입력해보자

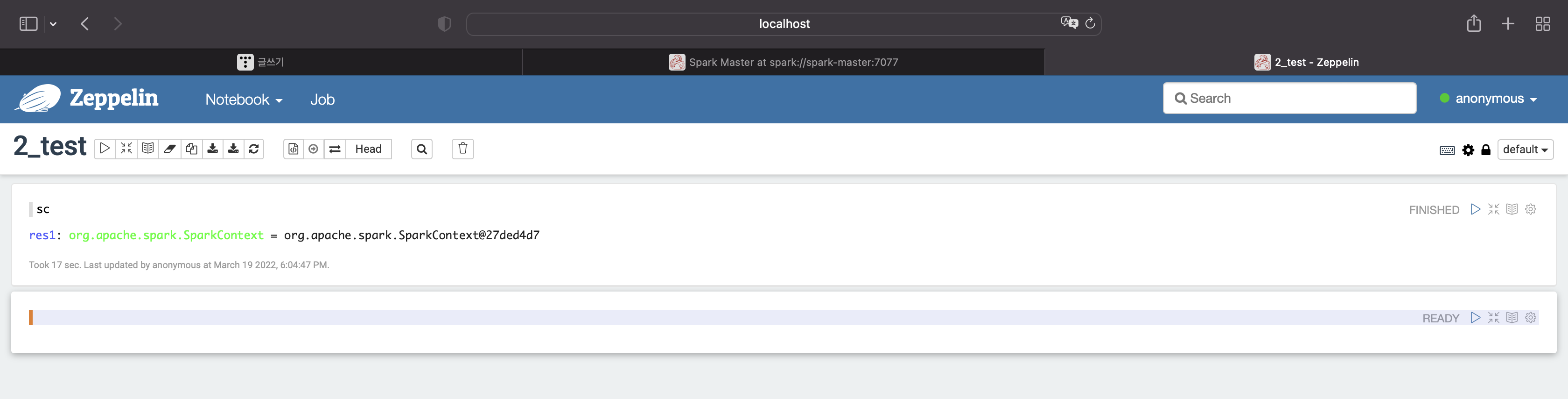

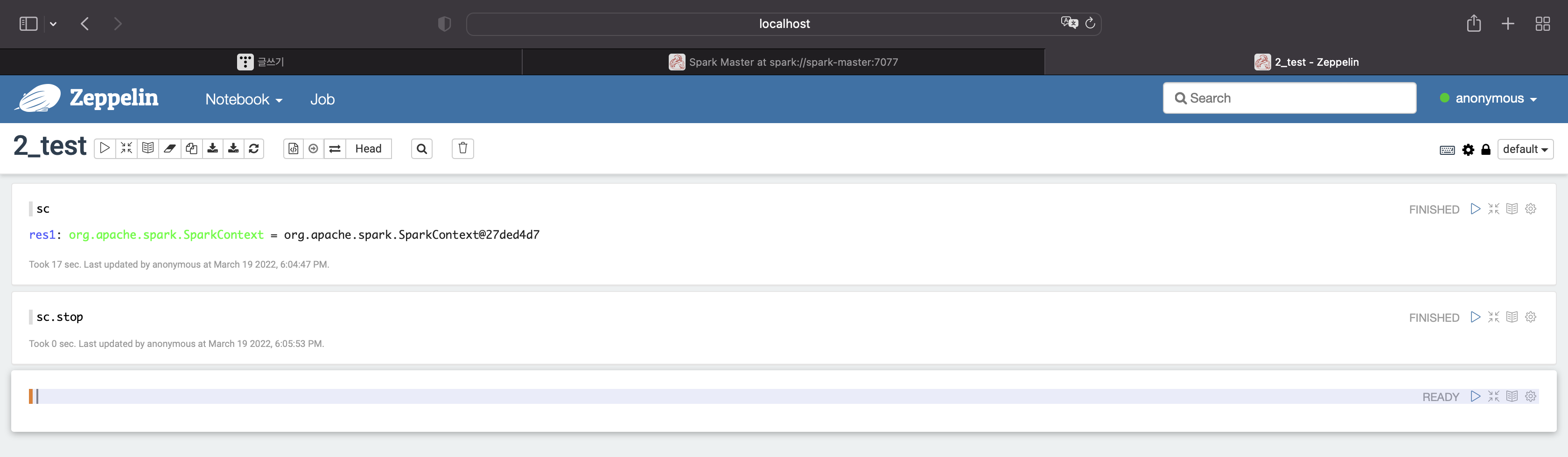

sc

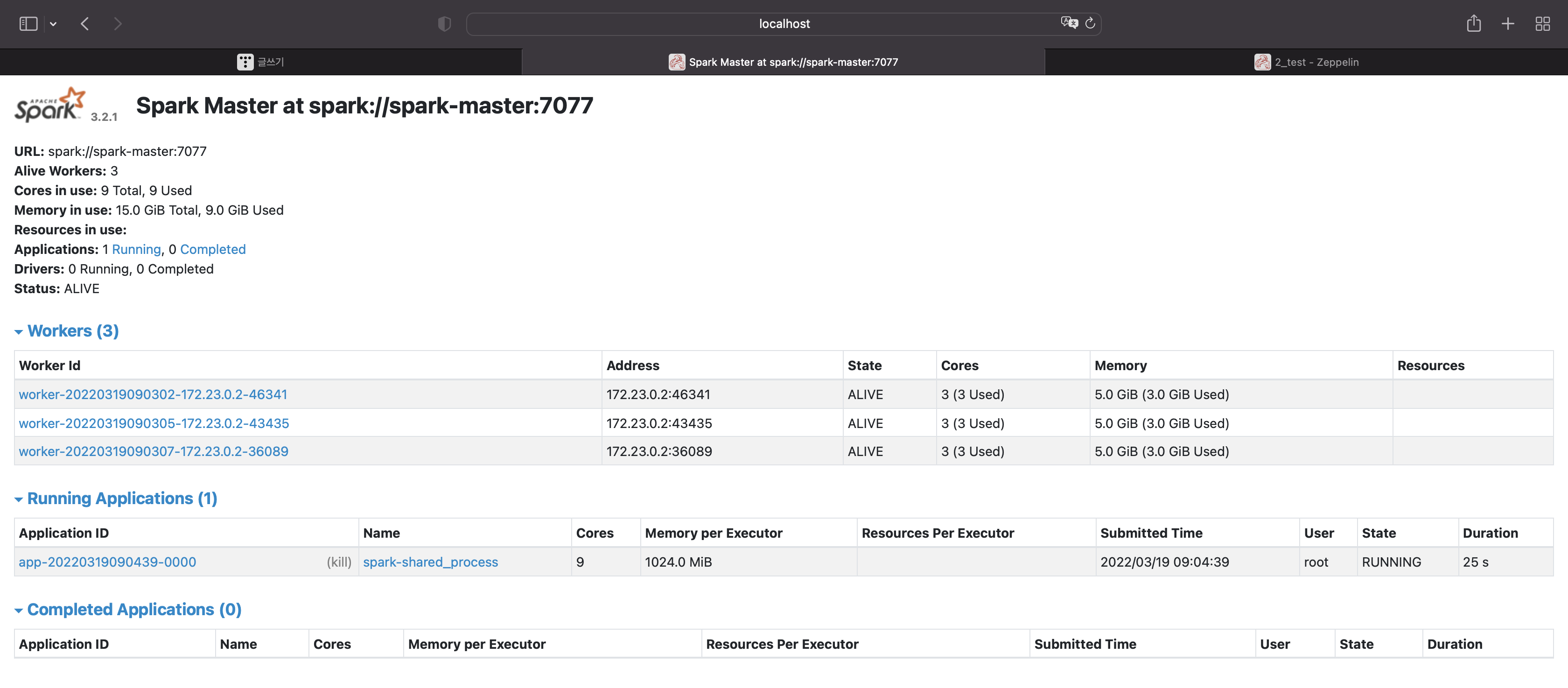

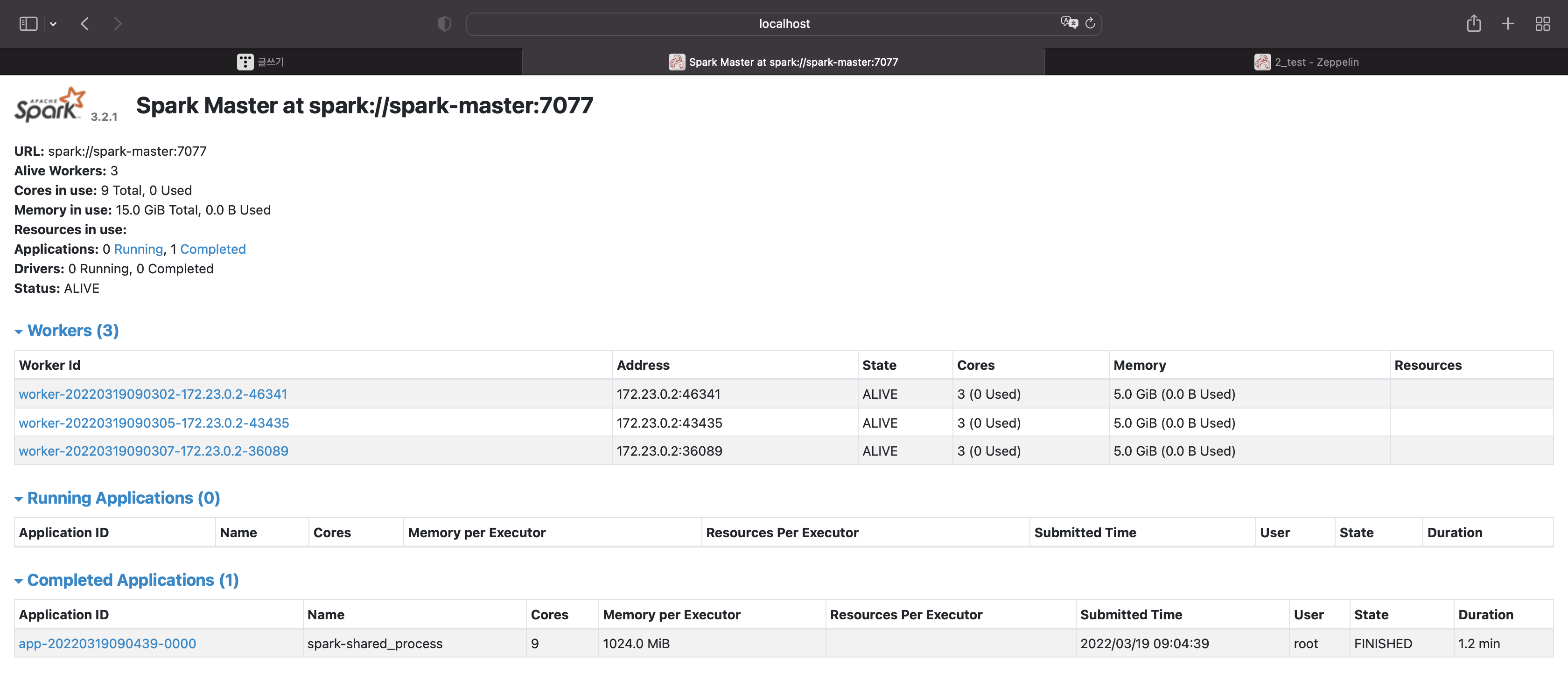

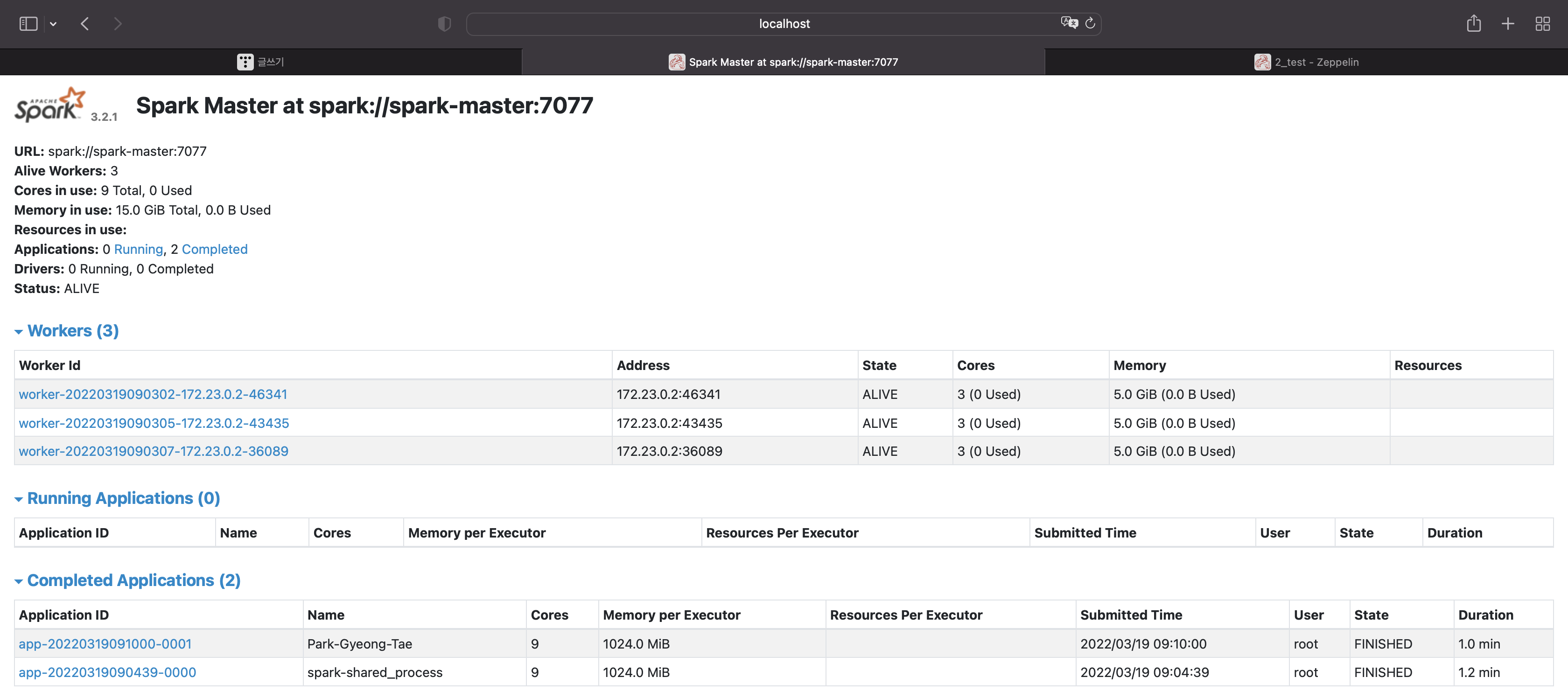

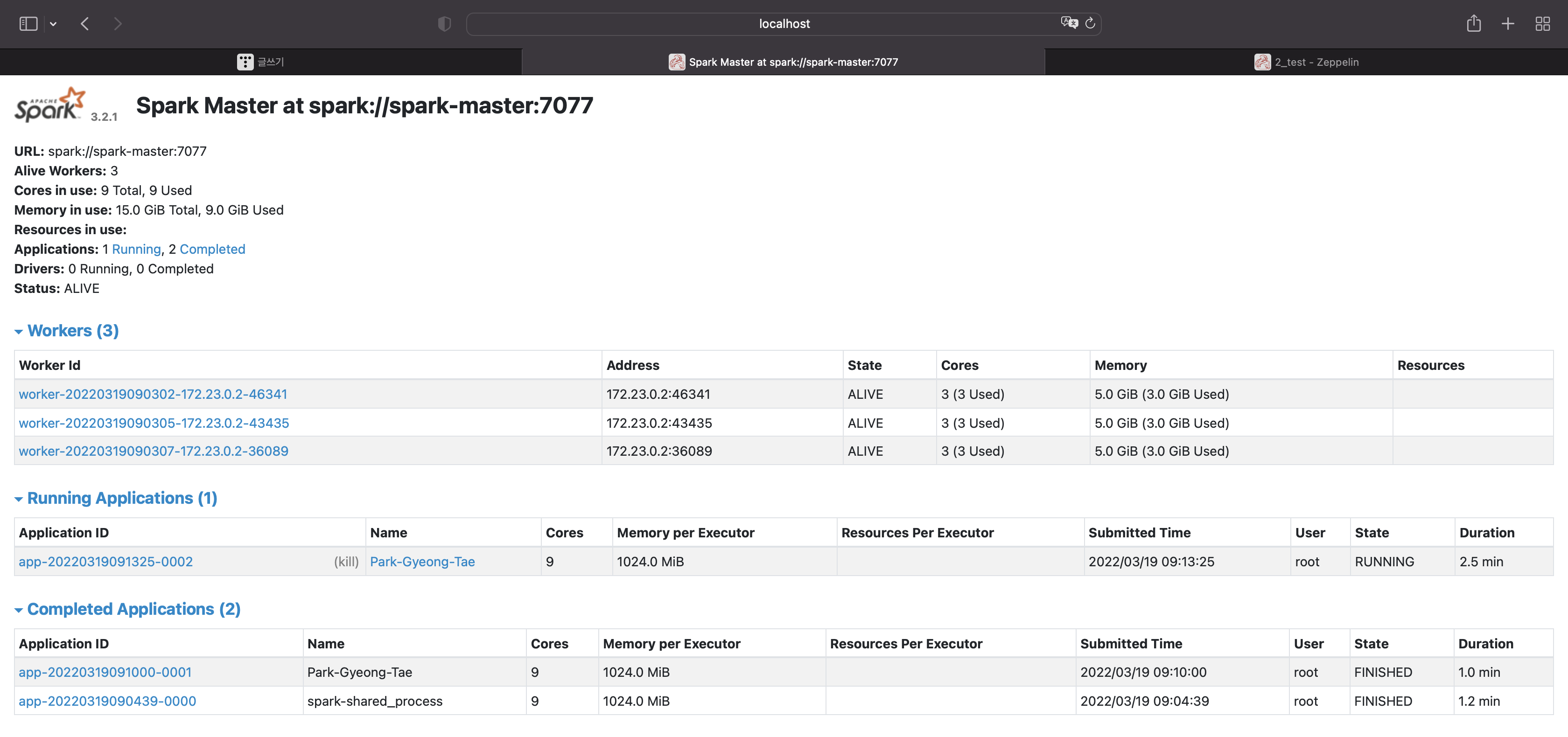

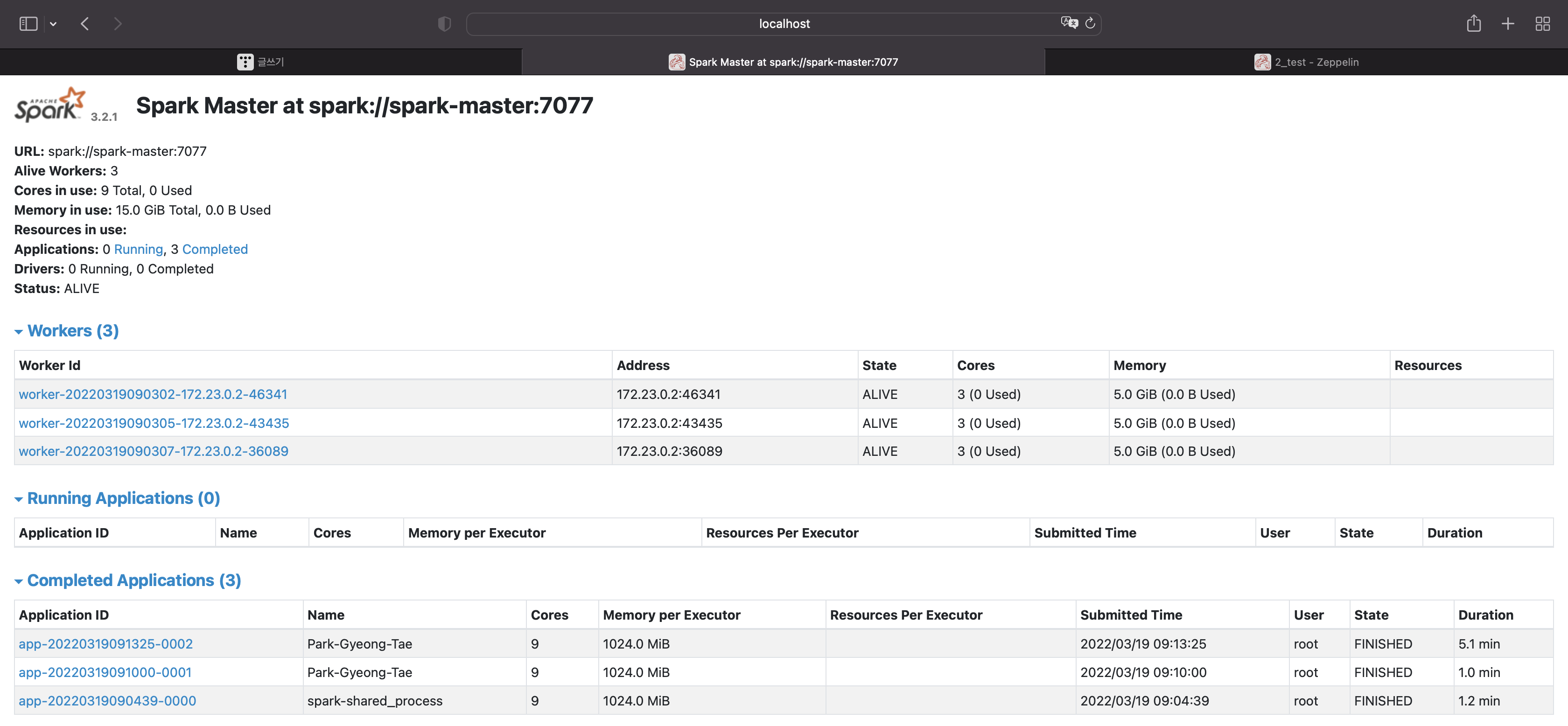

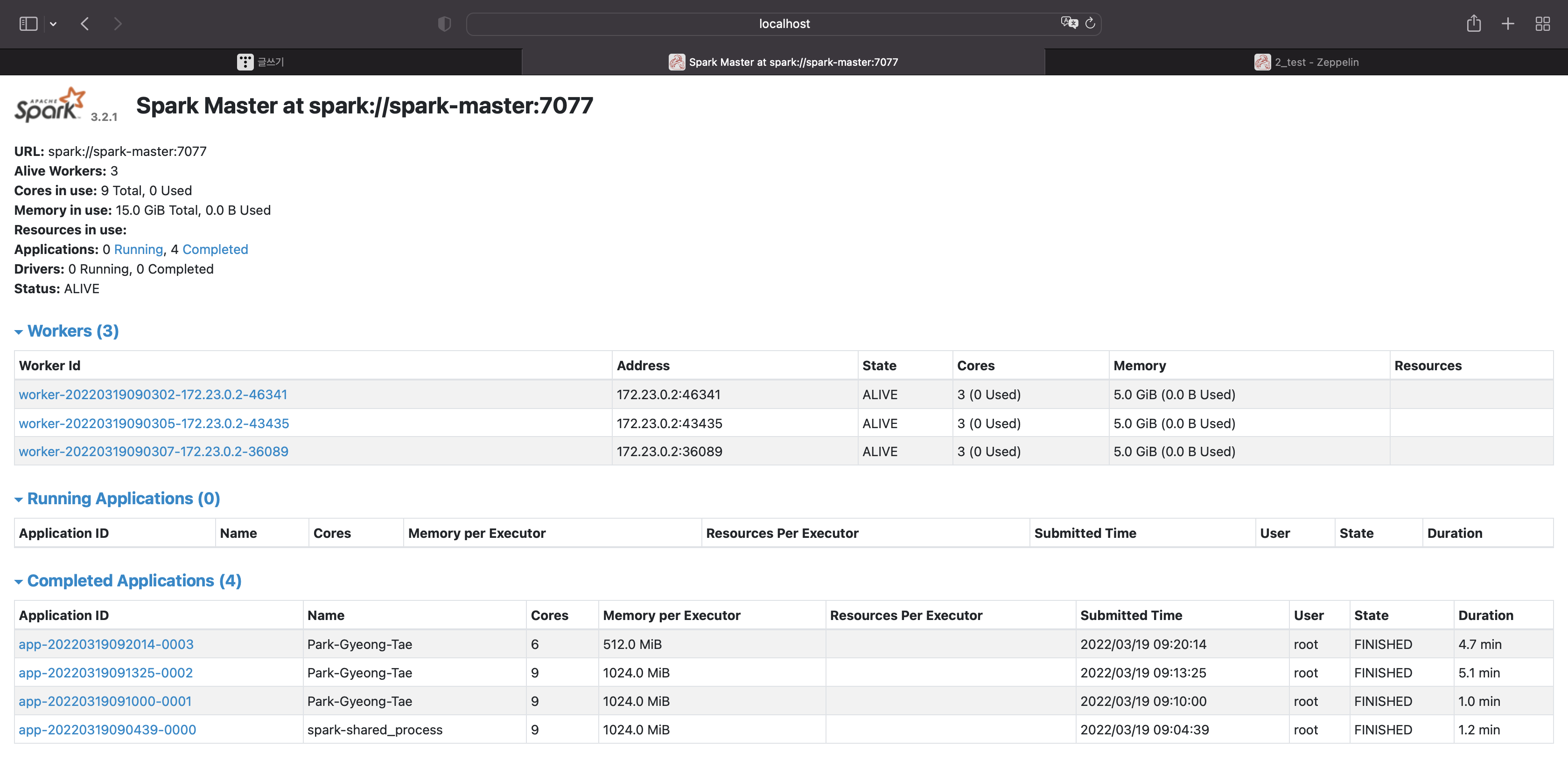

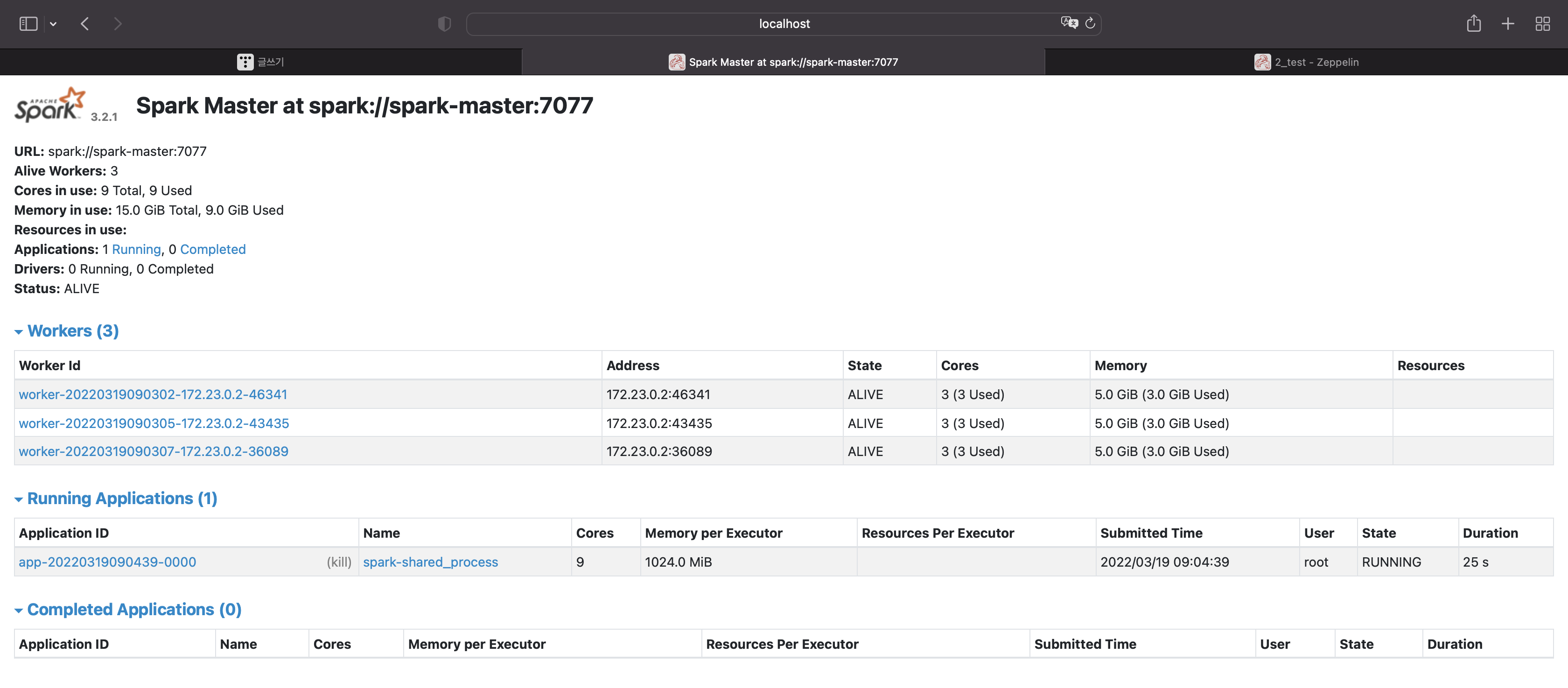

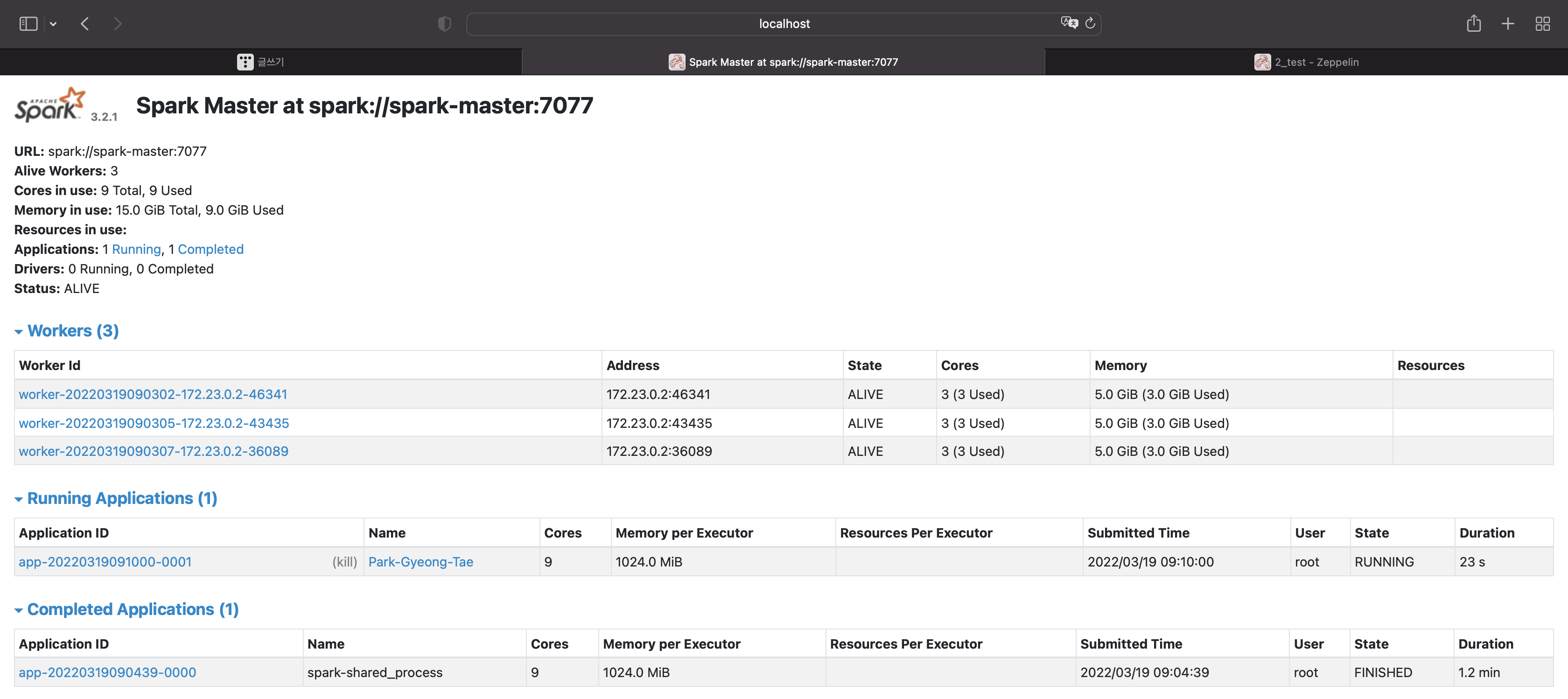

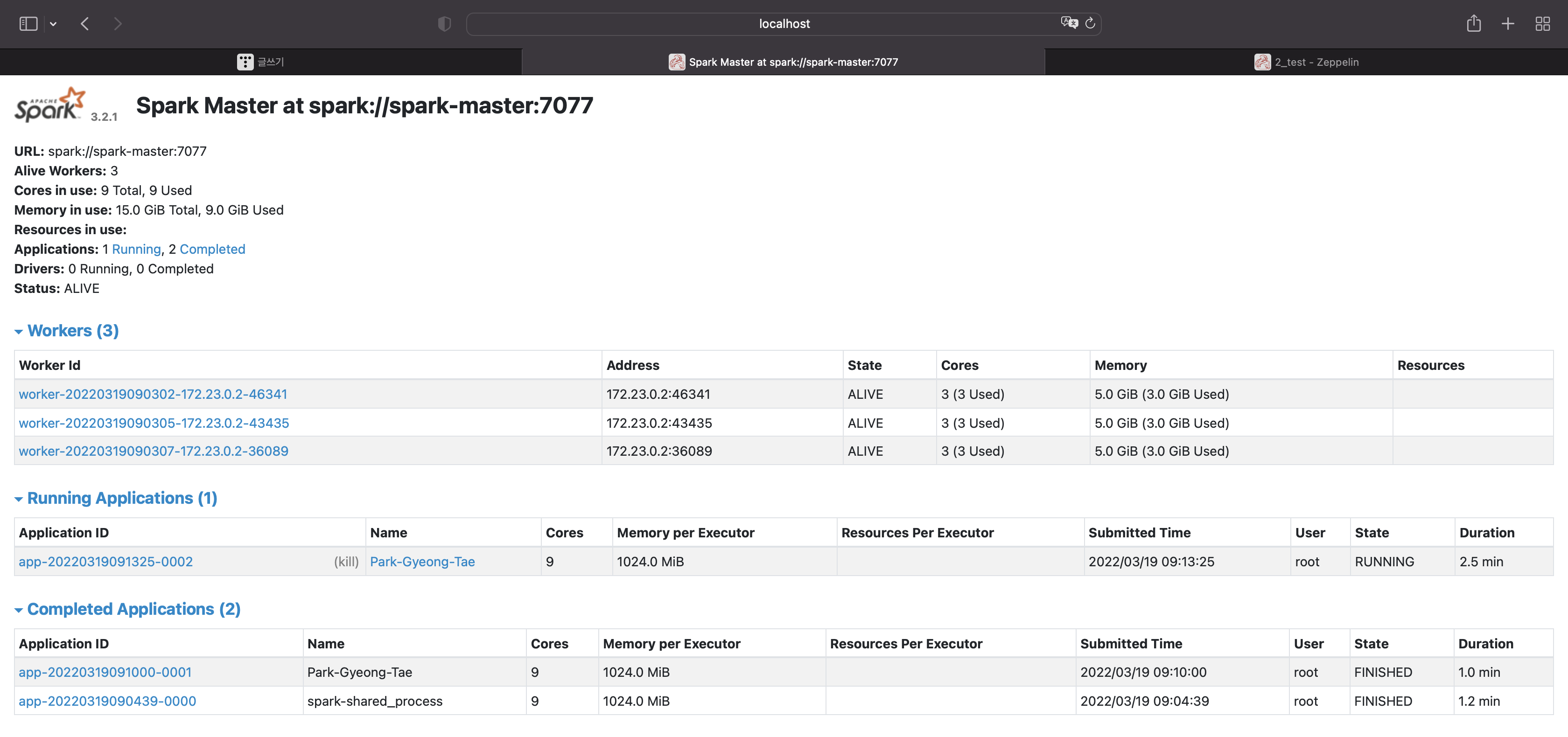

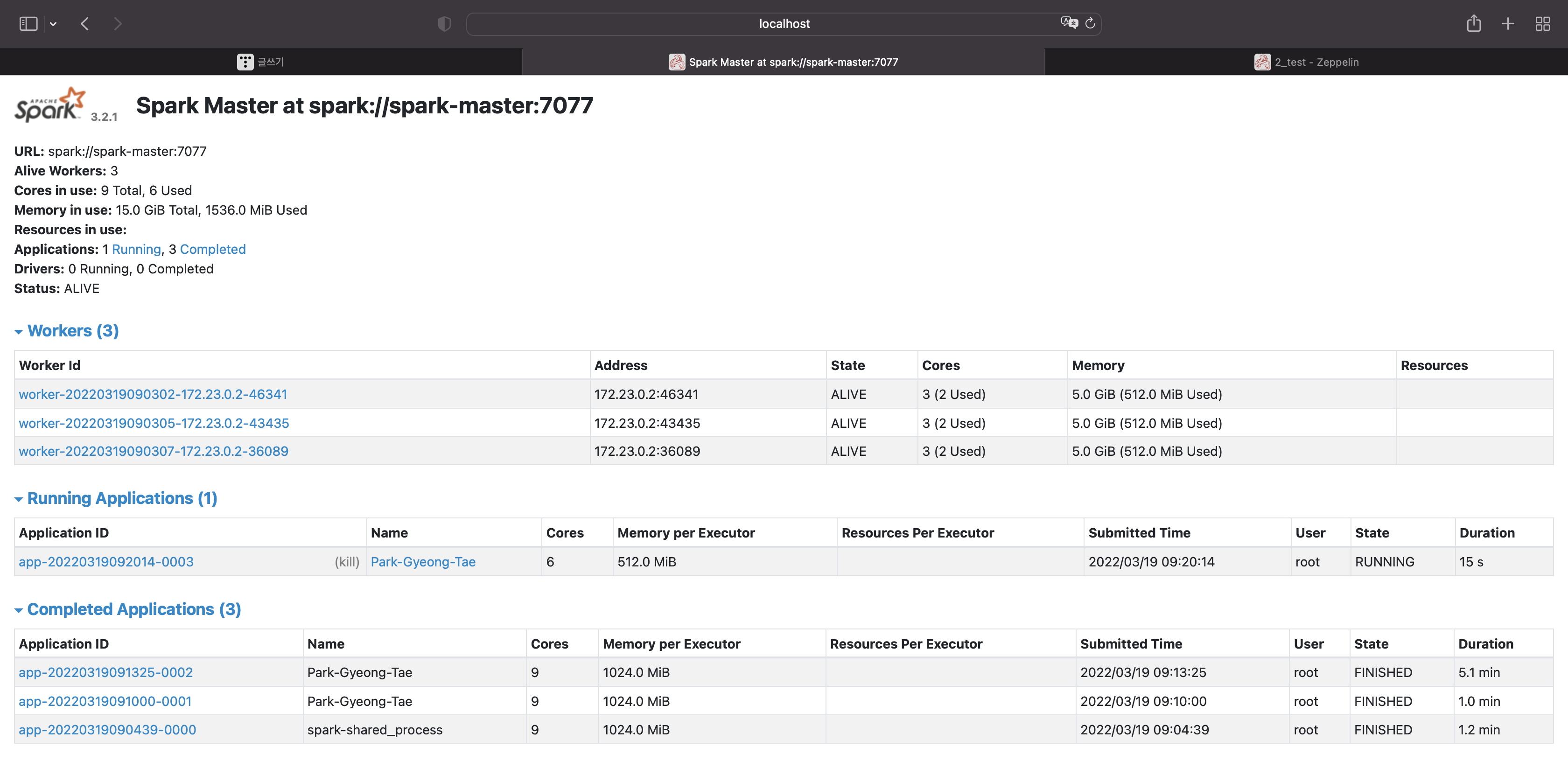

스파크 ui를 보자

앱이 하나 실행됐고,

코어당 1기가의 메모리를 사용하는 것으로 총 9기가의 메모리를 사용하는 앱이 실행됐다.

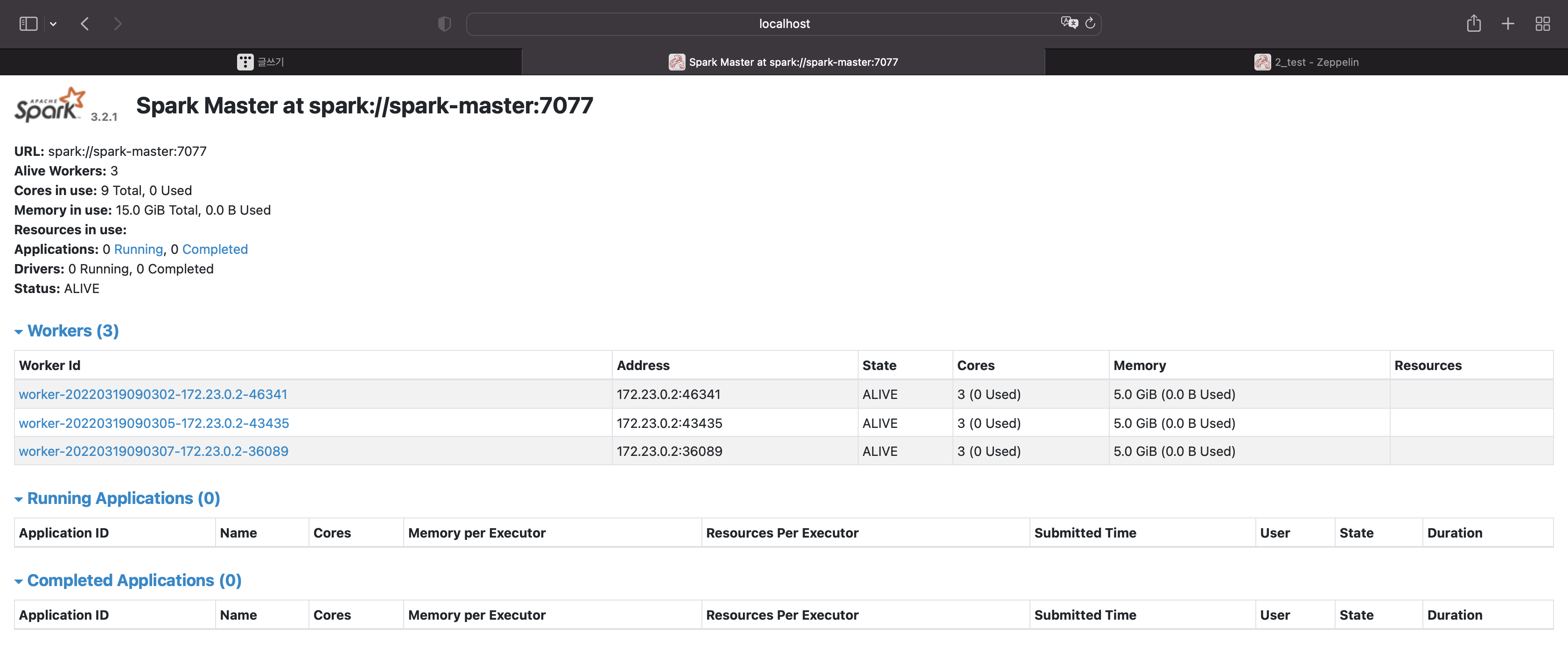

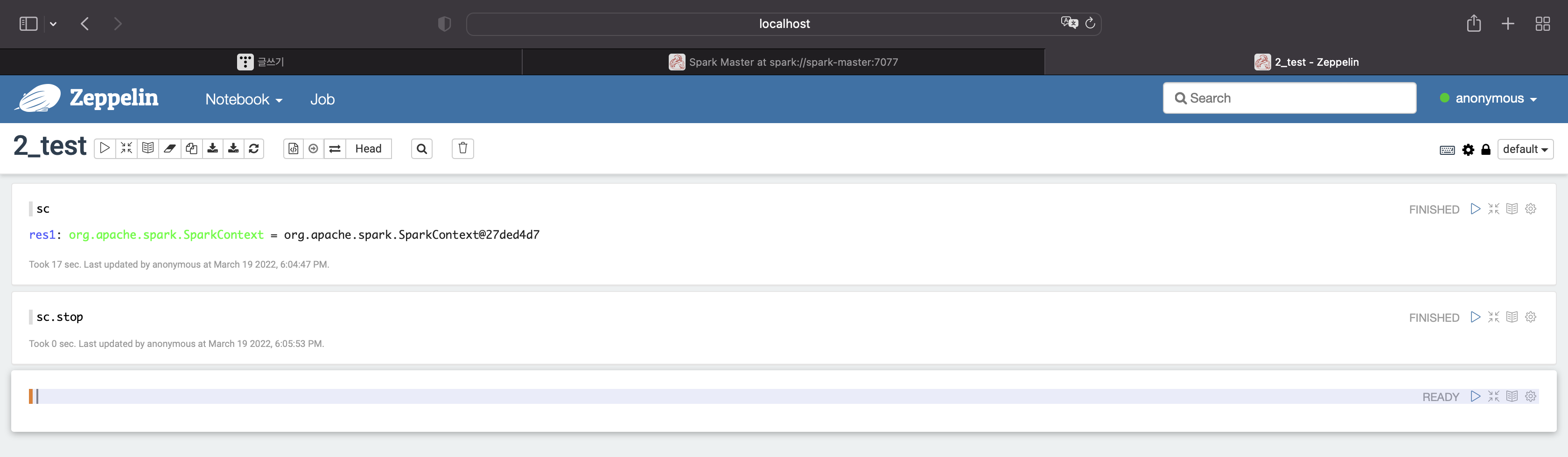

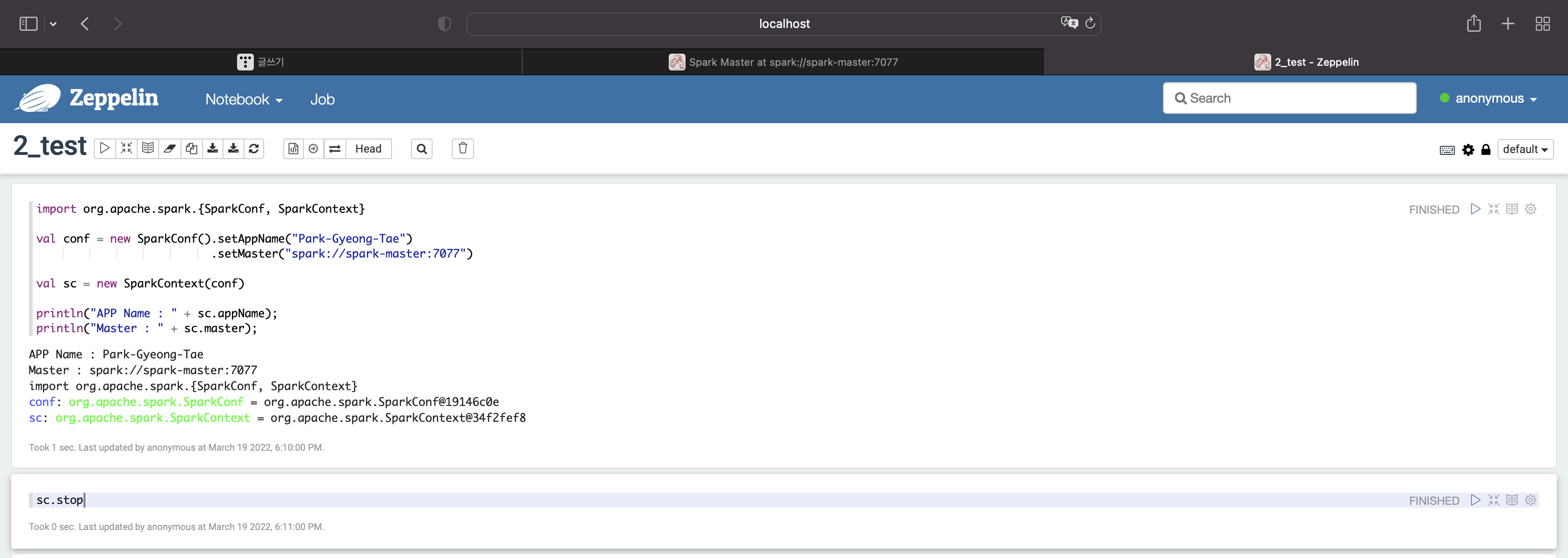

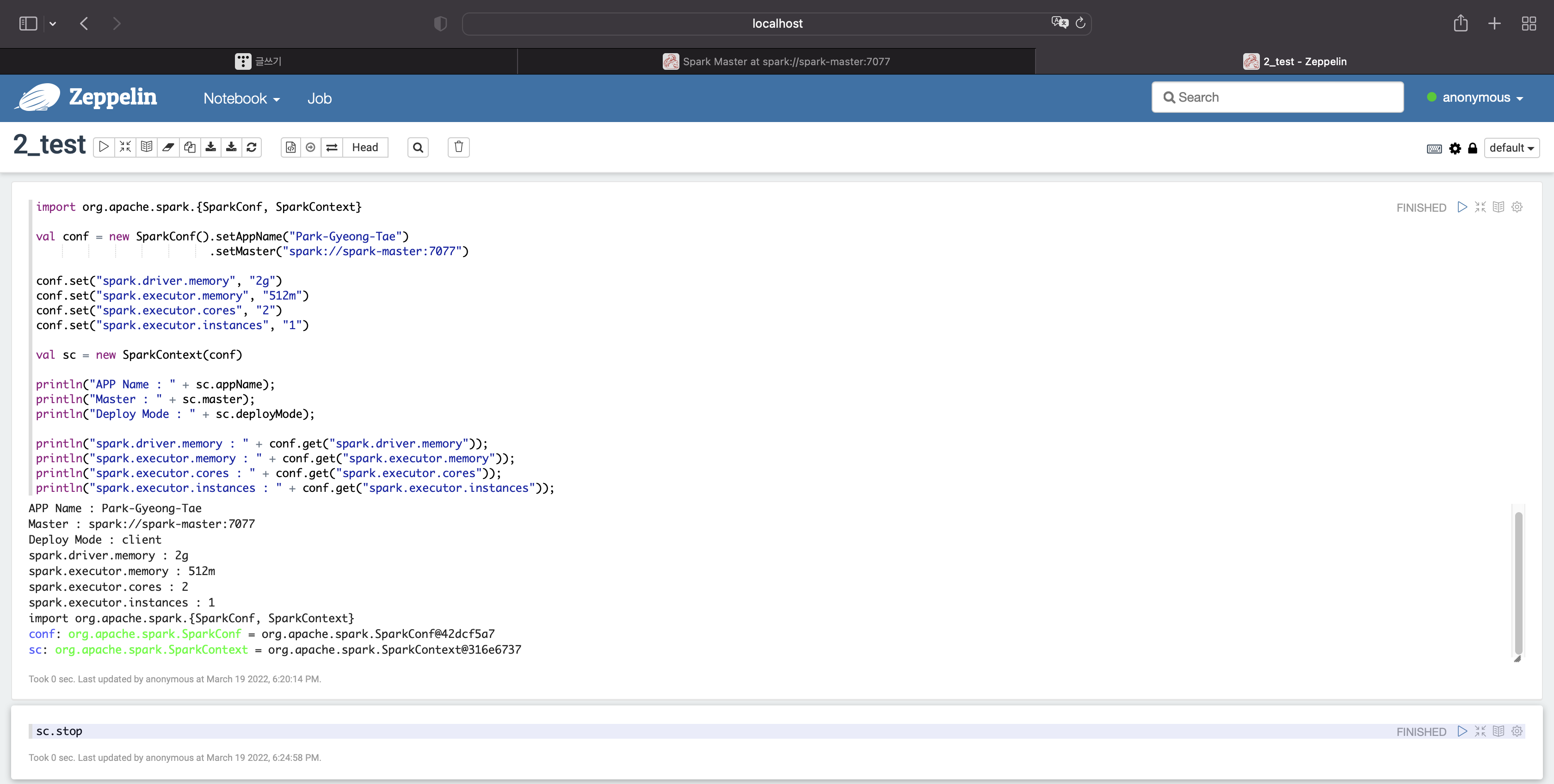

앱을 종료시켜보자

sc.stop

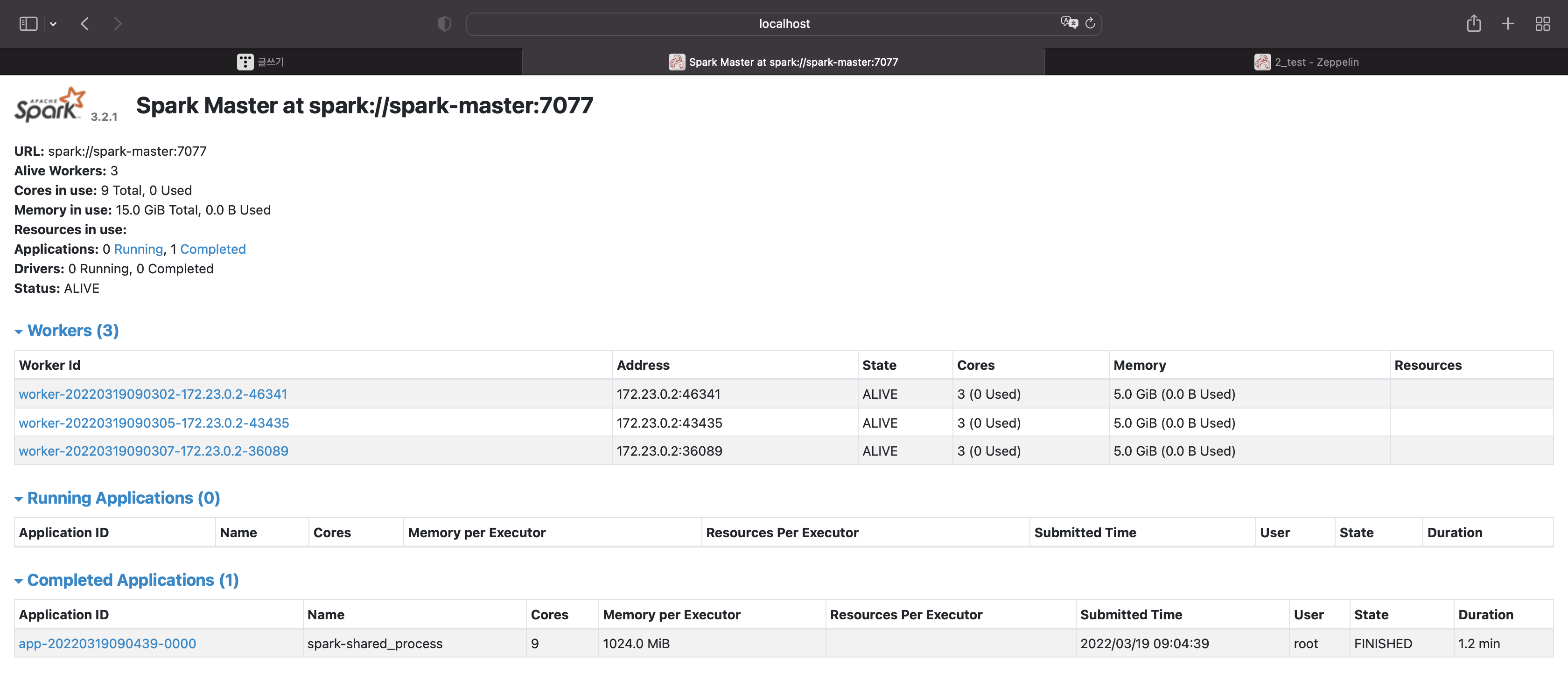

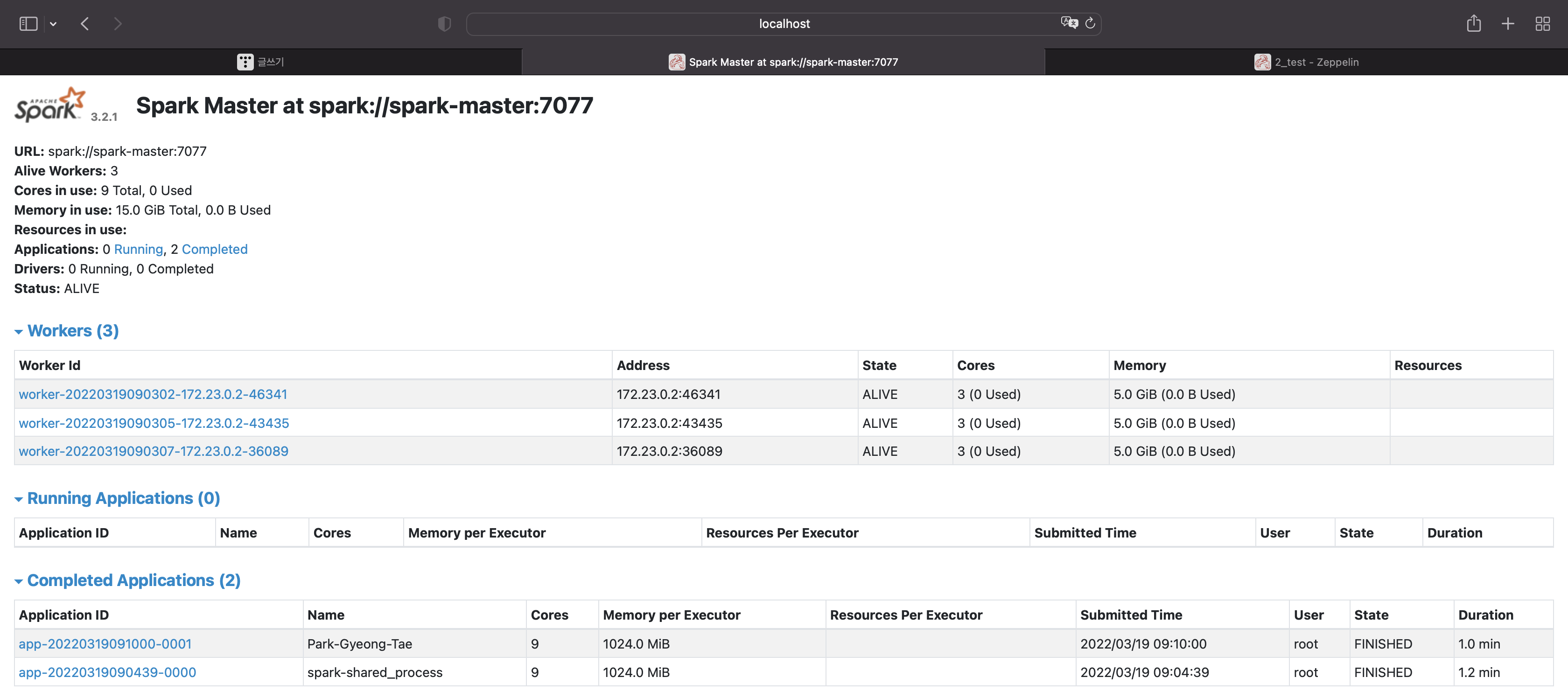

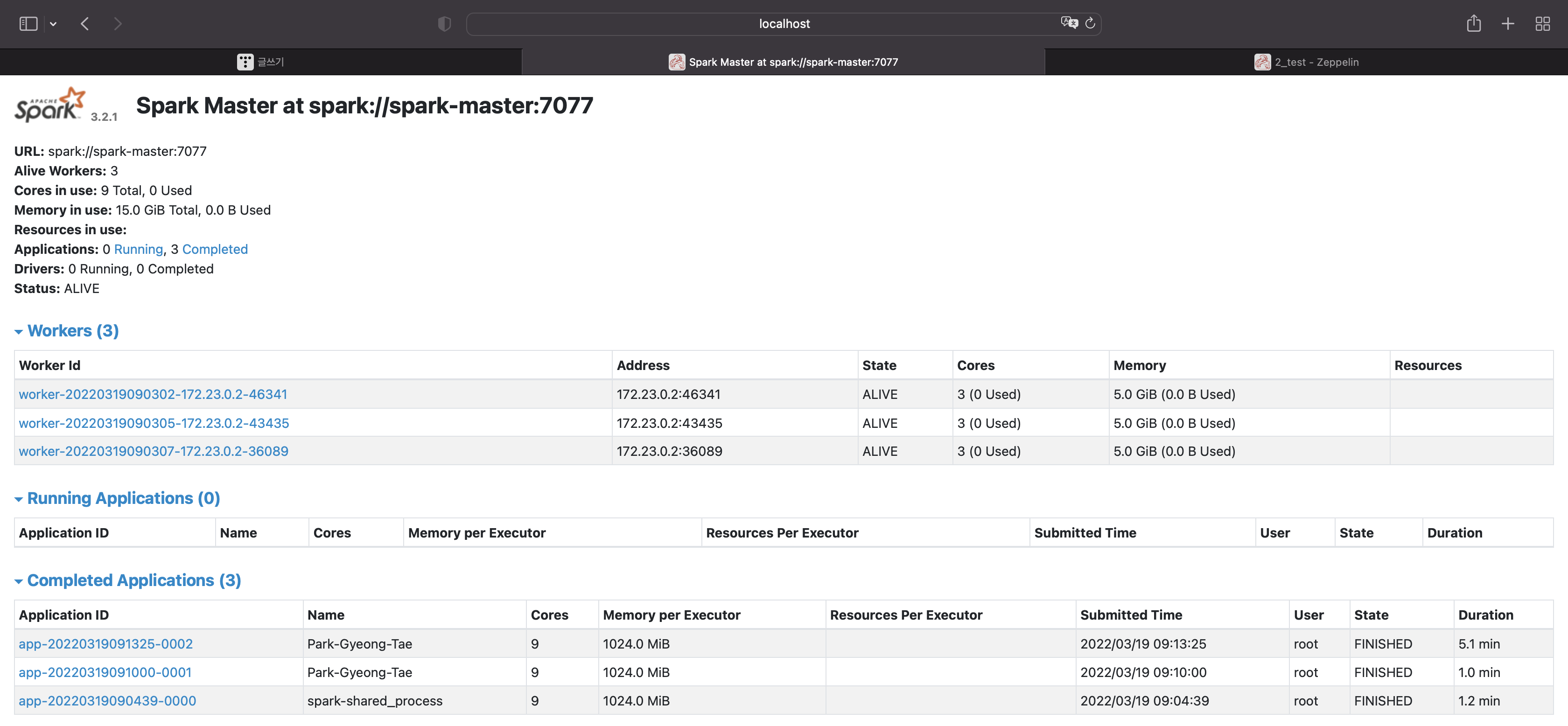

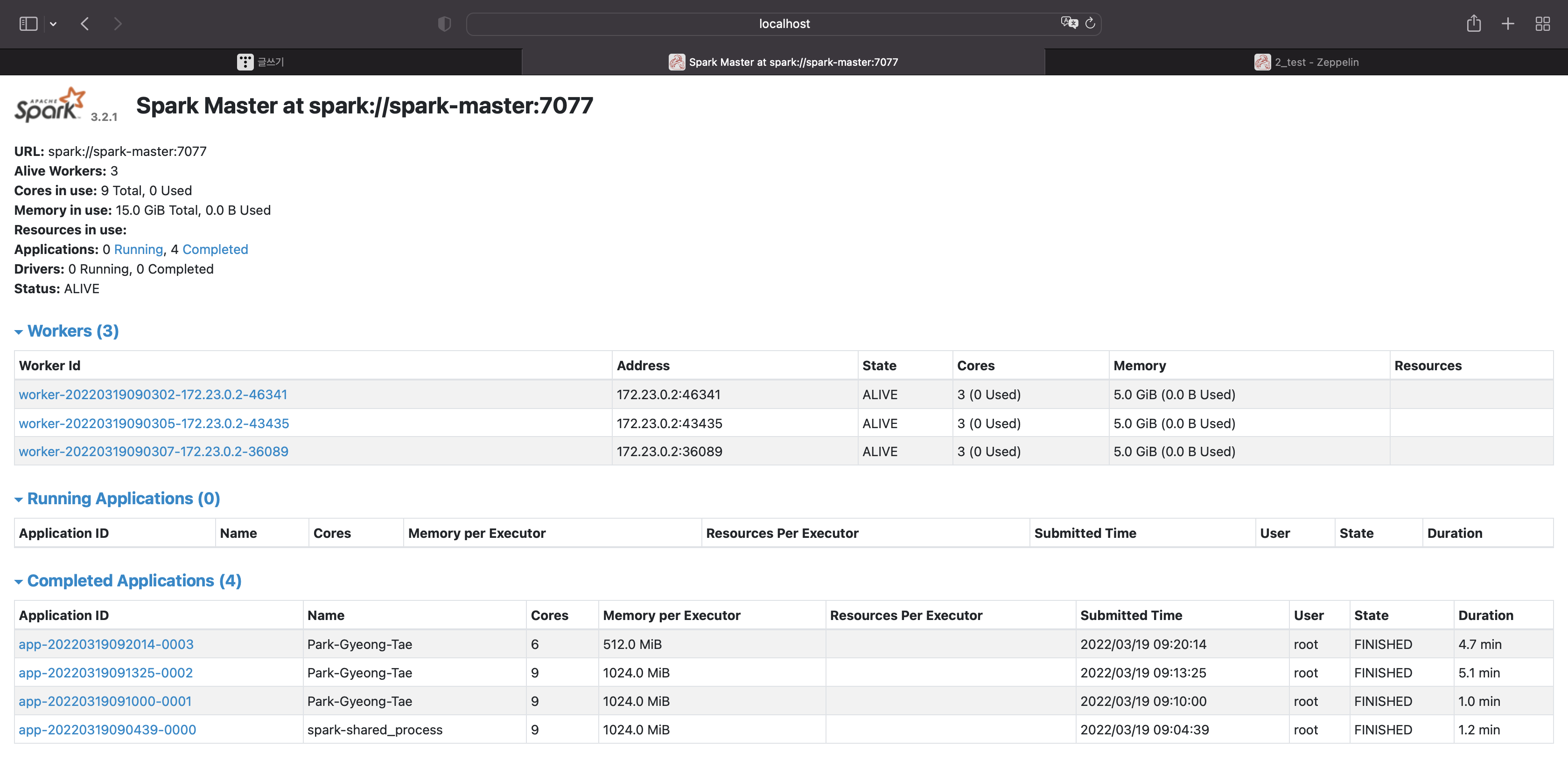

앱이 종료된 것을 확인할 수 있다.

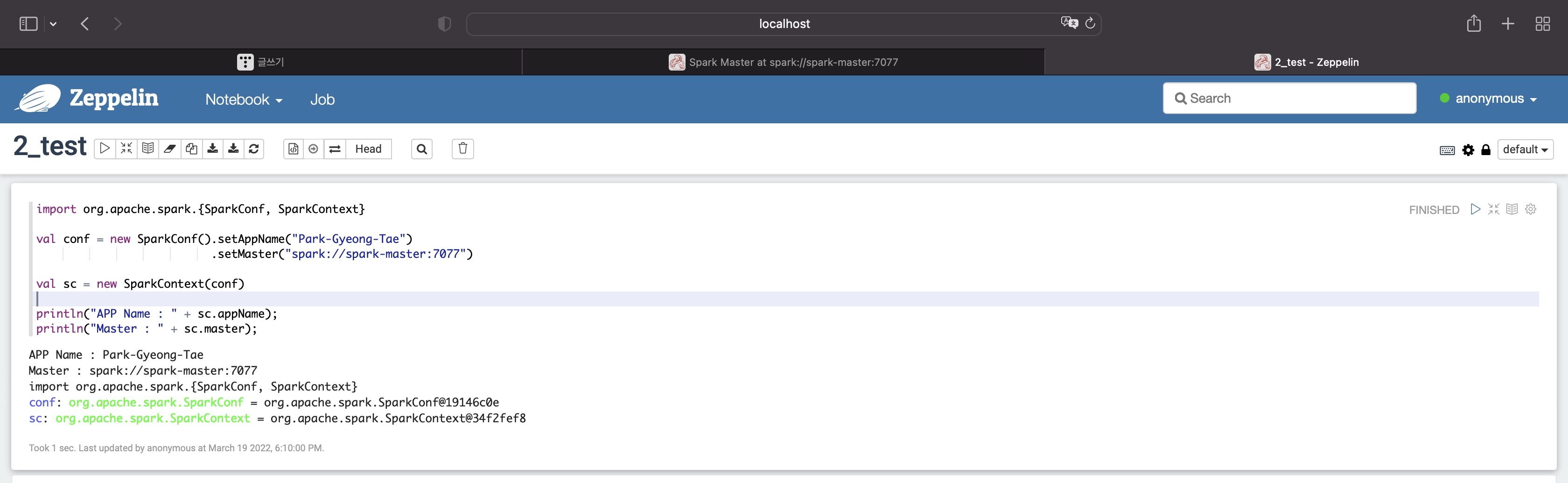

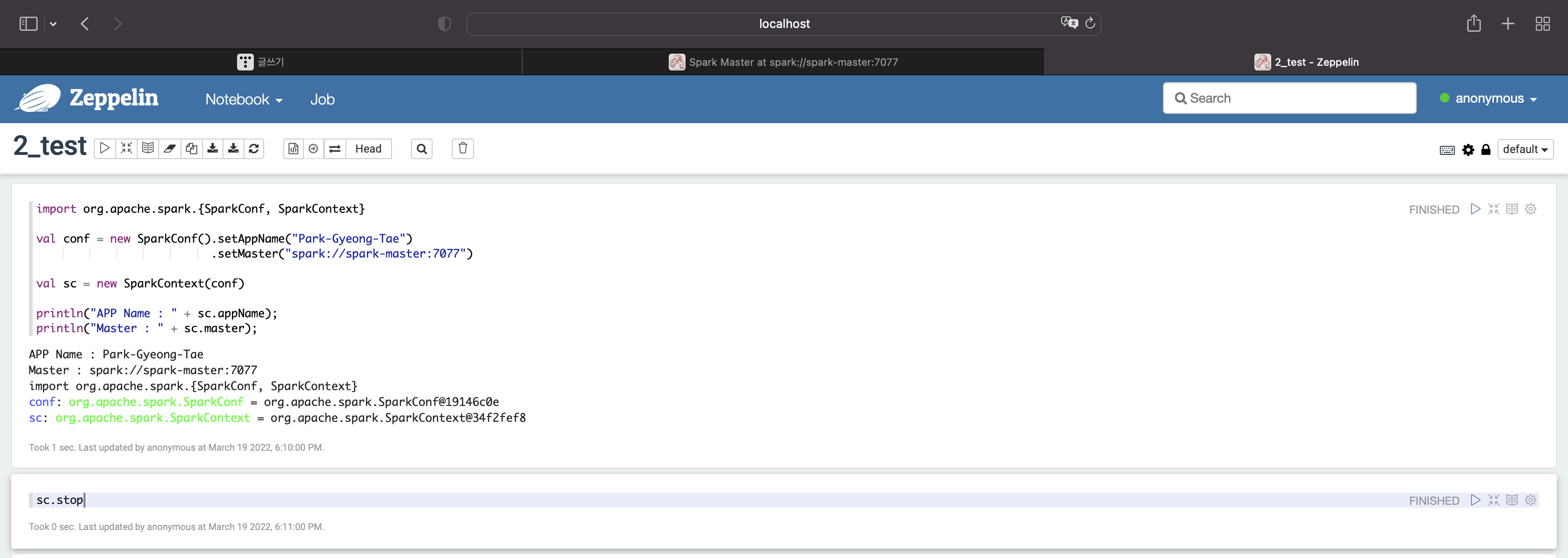

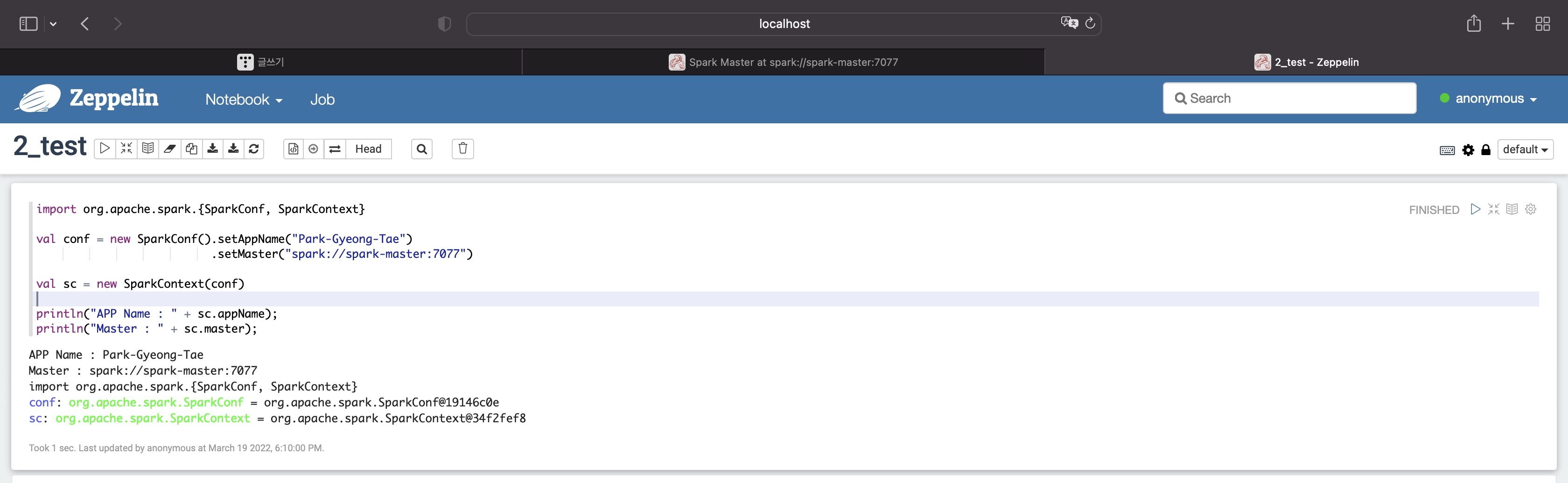

이번에는 내가 원하는 옵션을 취해보자

먼저 애플리케이션 이름을 설정해보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

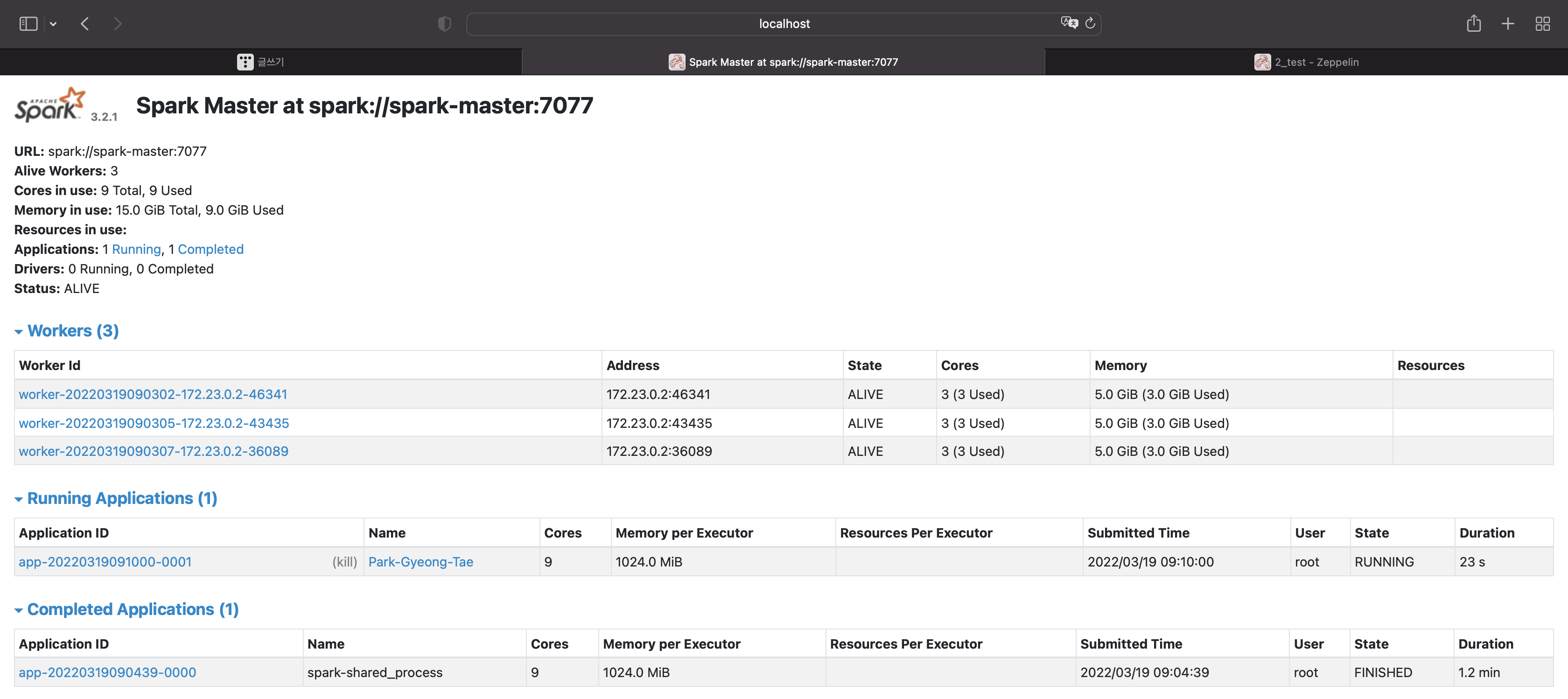

애플리케이션 이름이 바뀐 것을 확인할 수 있다.

종료시켜보자

sc.stop

종료됐다.

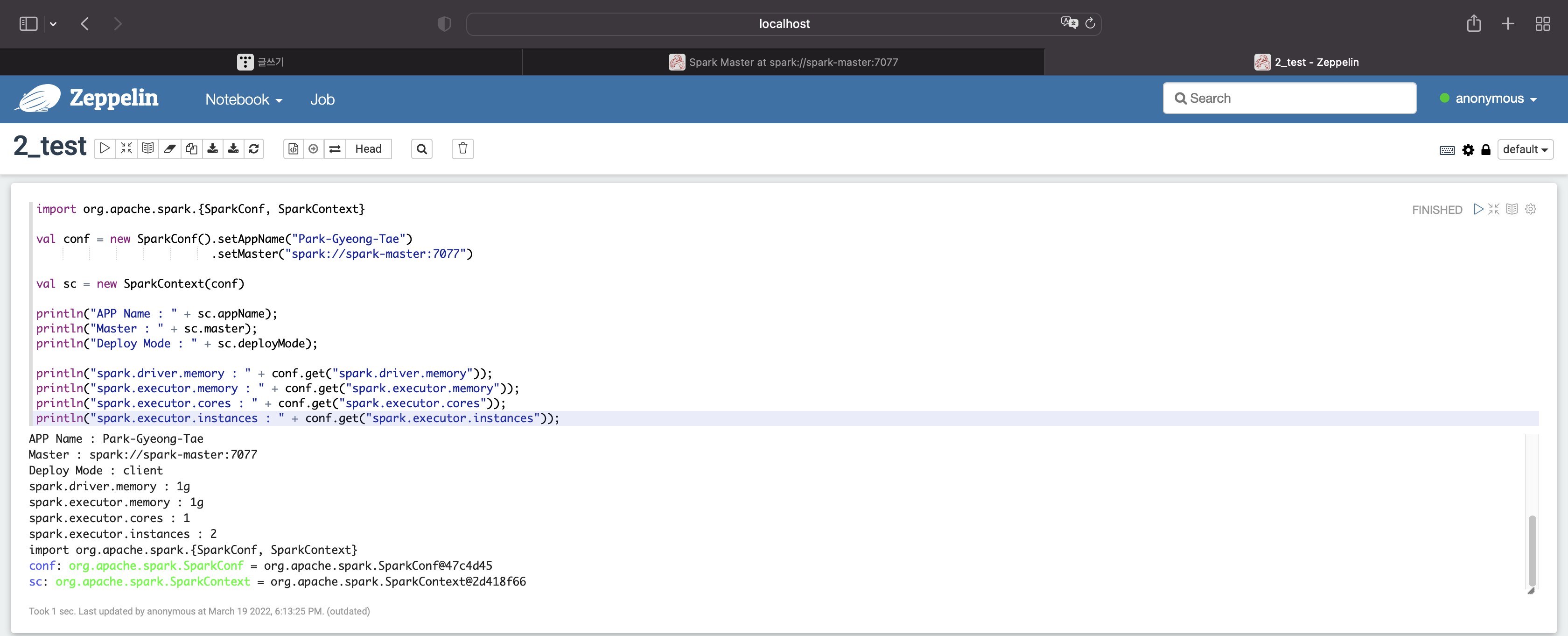

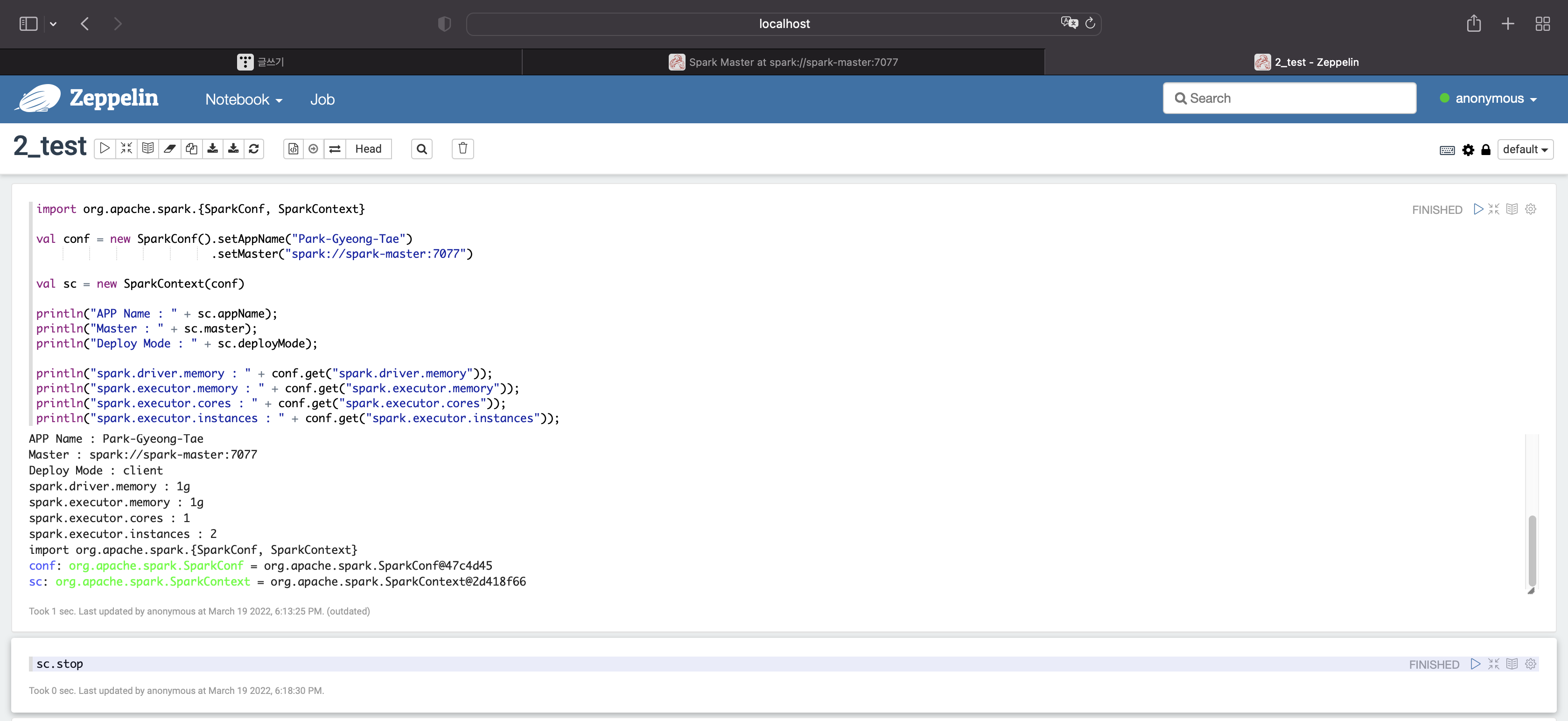

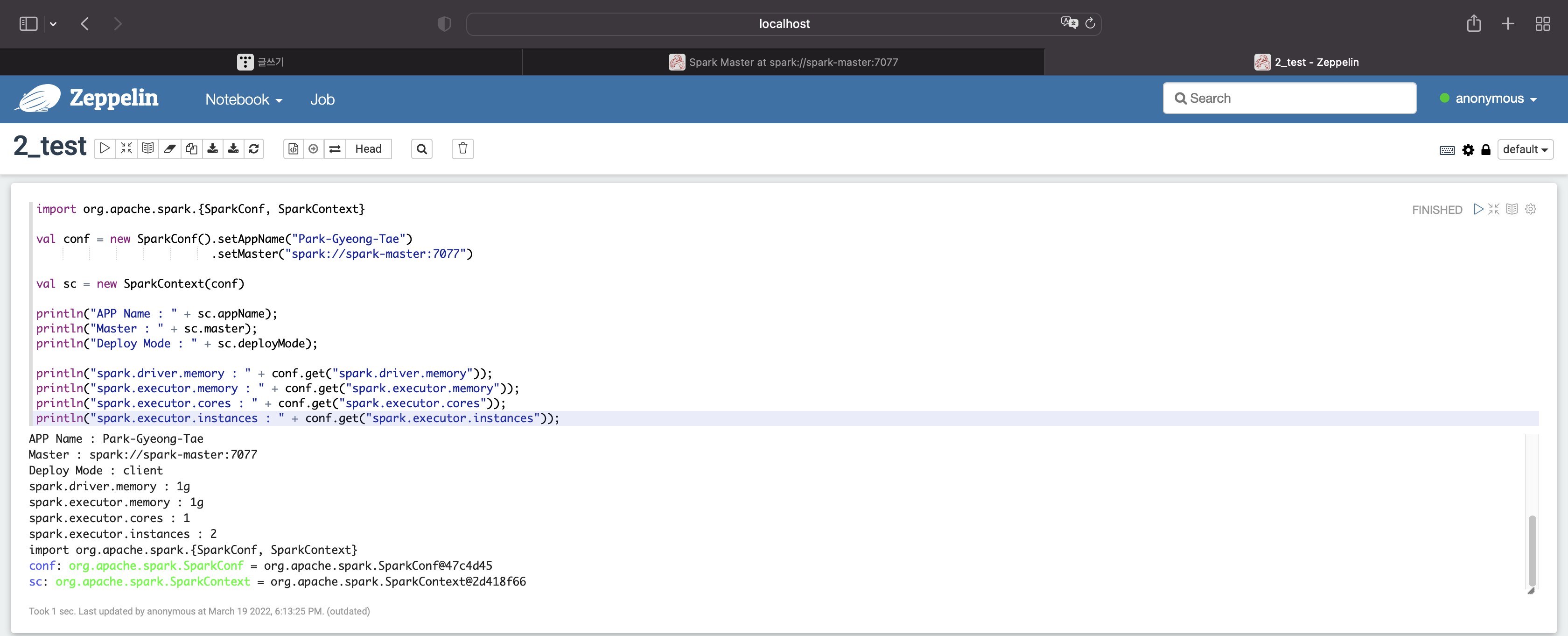

이번에는 다양한 옵션의 디폴트값을 확인해보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

println("Deploy Mode : " + sc.deployMode);

println("spark.driver.memory : " + conf.get("spark.driver.memory"));

println("spark.executor.memory : " + conf.get("spark.executor.memory"));

println("spark.executor.cores : " + conf.get("spark.executor.cores"));

println("spark.executor.instances : " + conf.get("spark.executor.instances"));

드라이버 메모리 : 1기가

익스큐터 메모리 : 1기가

익스큐터당 코어 : 1개

익스큐터당 인스턴스 : 2개

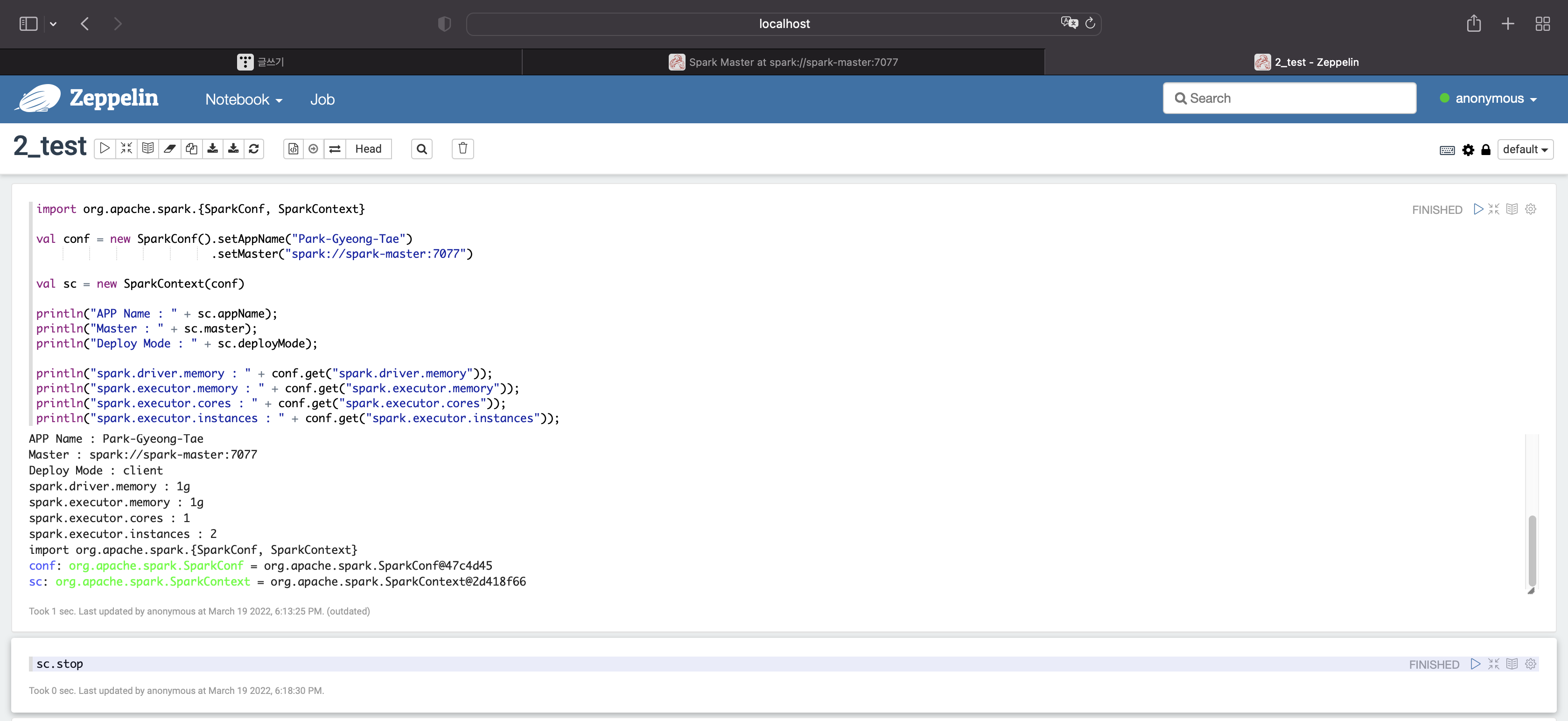

종료시켜보자

sc.stop

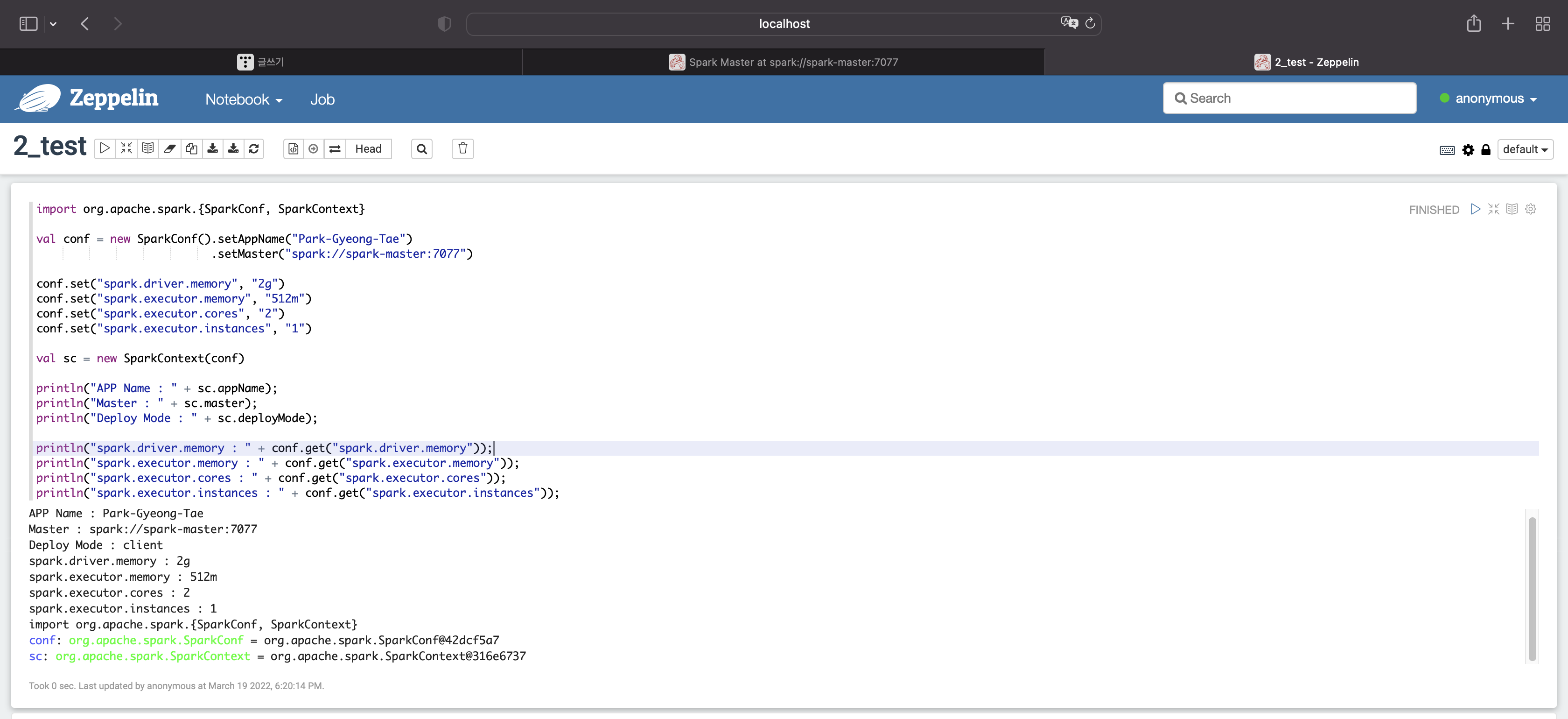

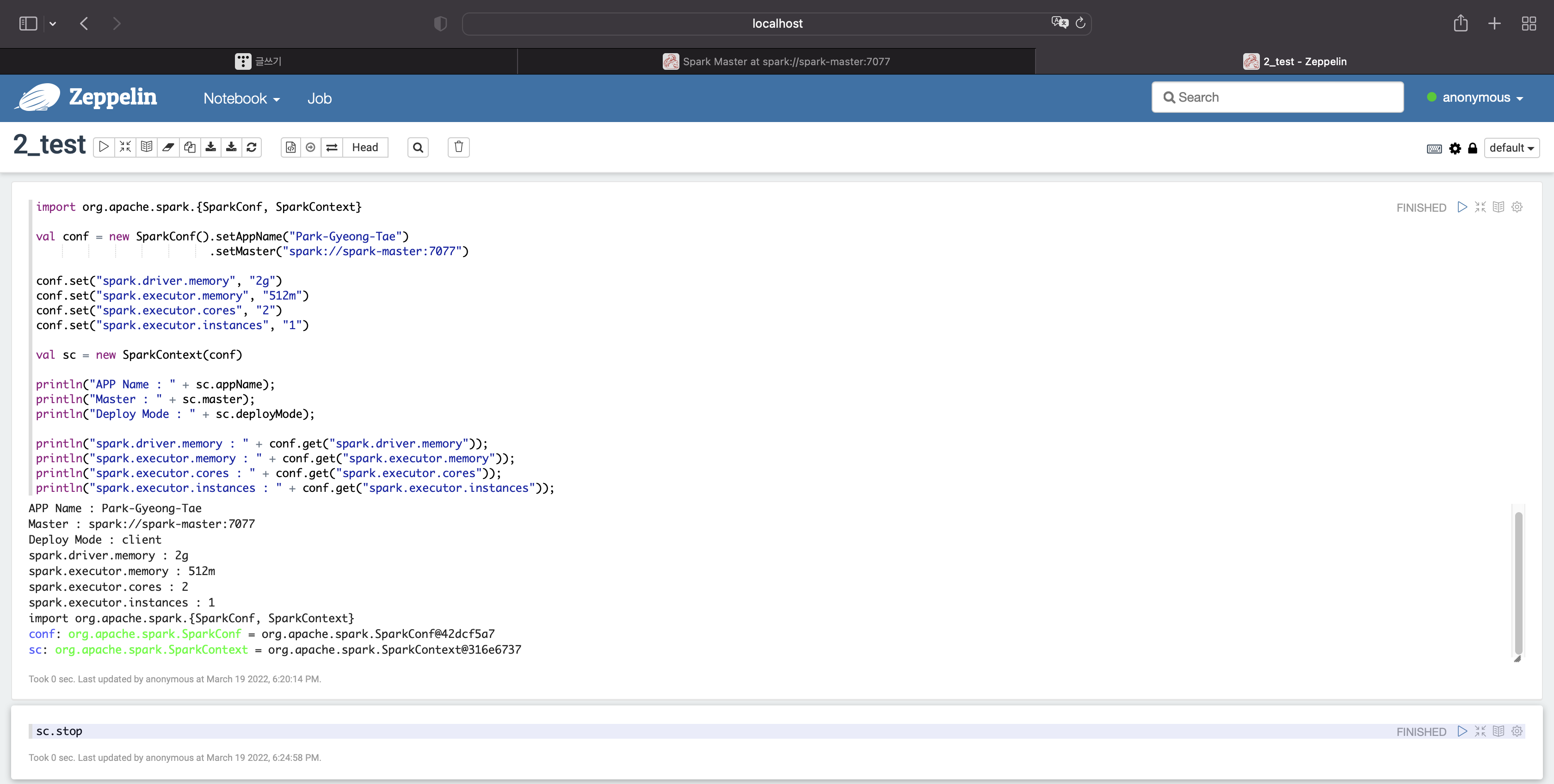

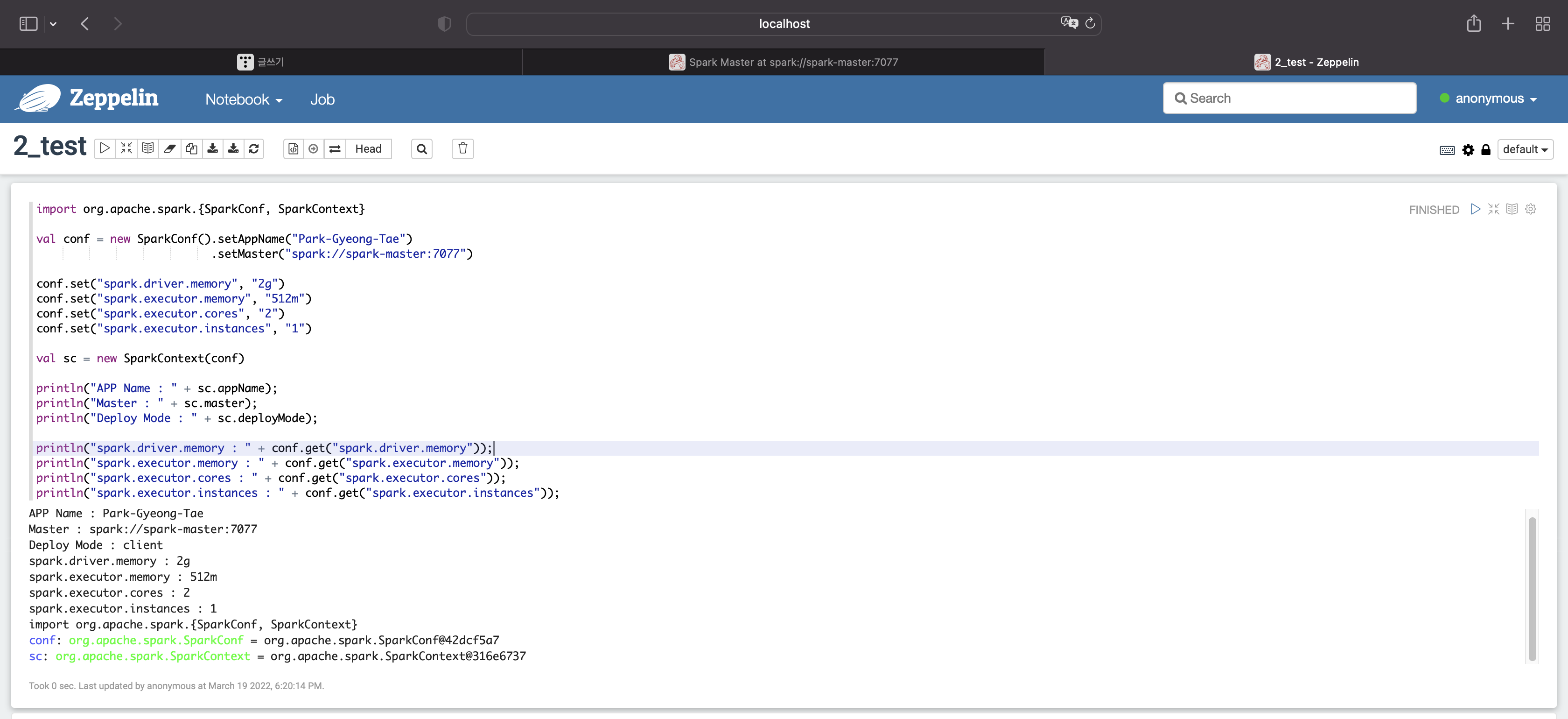

디폴트값을 변경시켜보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

conf.set("spark.driver.memory", "2g")

conf.set("spark.executor.memory", "512m")

conf.set("spark.executor.cores", "2")

conf.set("spark.executor.instances", "1")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

println("Deploy Mode : " + sc.deployMode);

println("spark.driver.memory : " + conf.get("spark.driver.memory"));

println("spark.executor.memory : " + conf.get("spark.executor.memory"));

println("spark.executor.cores : " + conf.get("spark.executor.cores"));

println("spark.executor.instances : " + conf.get("spark.executor.instances"));

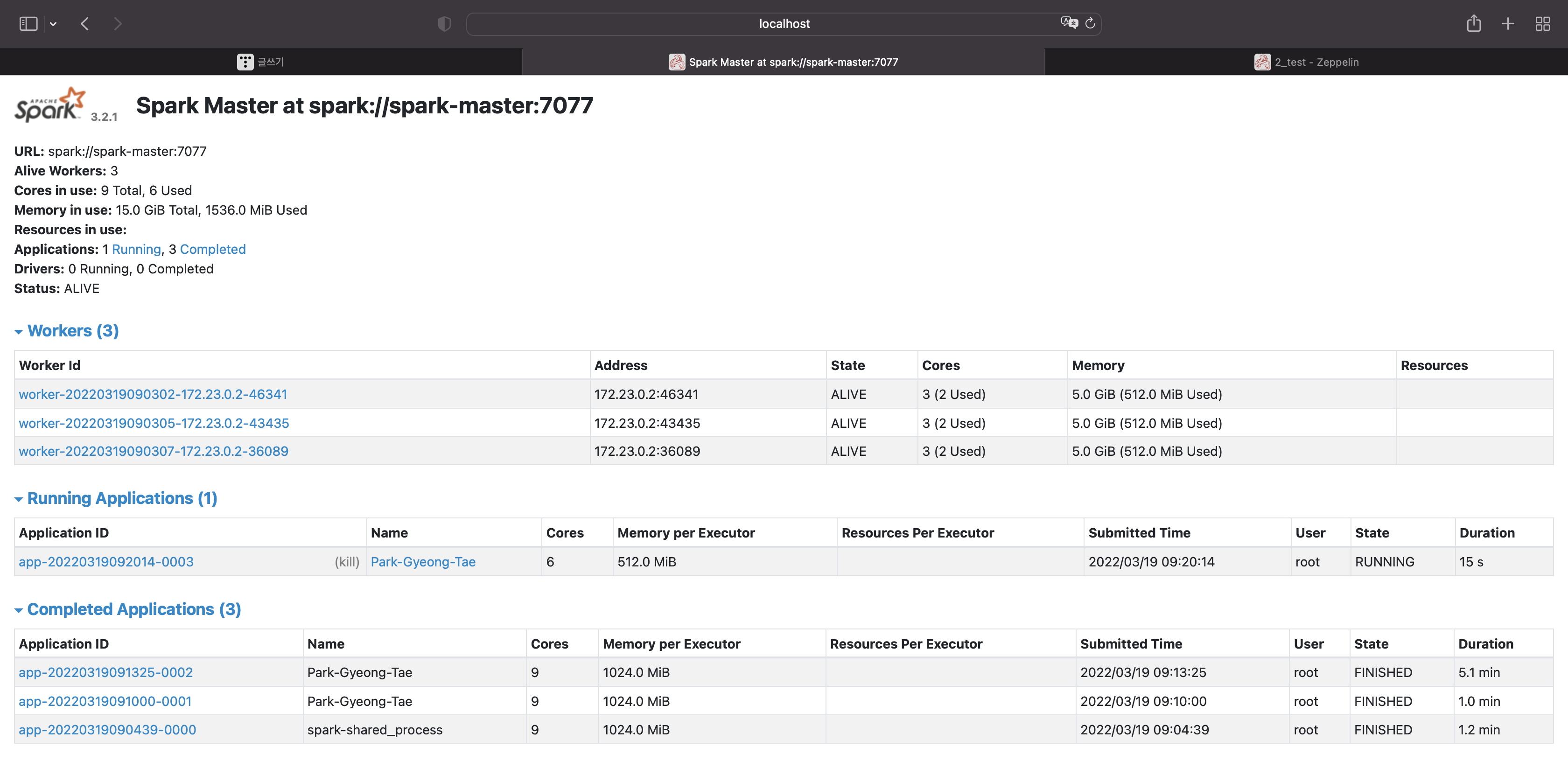

드라이버 메모리 : 2기가

익스큐터당 메모리 : 512메가

익스큐터당 코어수 : 2개

익스큐터당 인스턴스 수 : 1개

종료시키자

sc.stop

이 부분은 다음 블로그에서 자세히 알아보자

'Data Engineering > Spark' 카테고리의 다른 글

| [Spark] 로컬에서 스파크 클러스터 테스트시 사용하는 dockerfile (0) | 2022.03.20 |

|---|---|

| [Spark] 제플린에서 spark context 옵션에 대해 살펴보기 (0) | 2022.03.19 |

| [Spark] 아파치 스파크 클러스터와 제플린 실행시 jps 상태 확인 (0) | 2022.03.19 |

| [Spark] spark stand alone cluster, zeppline 사용시 jps, jdk 상태 (0) | 2022.03.18 |

| [Spark] zeppelin에서 spark application 실행하고 간단한 데이터 처리 (0) | 2022.03.18 |

스파크와 제플린을 실행시킨다.

스파크 ui

제플린

다음과 같이 입력해보자

sc

스파크 ui를 보자

앱이 하나 실행됐고,

코어당 1기가의 메모리를 사용하는 것으로 총 9기가의 메모리를 사용하는 앱이 실행됐다.

앱을 종료시켜보자

sc.stop

앱이 종료된 것을 확인할 수 있다.

이번에는 내가 원하는 옵션을 취해보자

먼저 애플리케이션 이름을 설정해보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

애플리케이션 이름이 바뀐 것을 확인할 수 있다.

종료시켜보자

sc.stop

종료됐다.

이번에는 다양한 옵션의 디폴트값을 확인해보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

println("Deploy Mode : " + sc.deployMode);

println("spark.driver.memory : " + conf.get("spark.driver.memory"));

println("spark.executor.memory : " + conf.get("spark.executor.memory"));

println("spark.executor.cores : " + conf.get("spark.executor.cores"));

println("spark.executor.instances : " + conf.get("spark.executor.instances"));

드라이버 메모리 : 1기가

익스큐터 메모리 : 1기가

익스큐터당 코어 : 1개

익스큐터당 인스턴스 : 2개

종료시켜보자

sc.stop

디폴트값을 변경시켜보자

import org.apache.spark.{SparkConf, SparkContext}

val conf = new SparkConf().setAppName("Park-Gyeong-Tae")

.setMaster("spark://spark-master:7077")

conf.set("spark.driver.memory", "2g")

conf.set("spark.executor.memory", "512m")

conf.set("spark.executor.cores", "2")

conf.set("spark.executor.instances", "1")

val sc = new SparkContext(conf)

println("APP Name : " + sc.appName);

println("Master : " + sc.master);

println("Deploy Mode : " + sc.deployMode);

println("spark.driver.memory : " + conf.get("spark.driver.memory"));

println("spark.executor.memory : " + conf.get("spark.executor.memory"));

println("spark.executor.cores : " + conf.get("spark.executor.cores"));

println("spark.executor.instances : " + conf.get("spark.executor.instances"));

드라이버 메모리 : 2기가

익스큐터당 메모리 : 512메가

익스큐터당 코어수 : 2개

익스큐터당 인스턴스 수 : 1개

종료시키자

sc.stop

이 부분은 다음 블로그에서 자세히 알아보자

'Data Engineering > Spark' 카테고리의 다른 글

| [Spark] 로컬에서 스파크 클러스터 테스트시 사용하는 dockerfile (0) | 2022.03.20 |

|---|---|

| [Spark] 제플린에서 spark context 옵션에 대해 살펴보기 (0) | 2022.03.19 |

| [Spark] 아파치 스파크 클러스터와 제플린 실행시 jps 상태 확인 (0) | 2022.03.19 |

| [Spark] spark stand alone cluster, zeppline 사용시 jps, jdk 상태 (0) | 2022.03.18 |

| [Spark] zeppelin에서 spark application 실행하고 간단한 데이터 처리 (0) | 2022.03.18 |