jdk 버전 : jdk-8u321-linux-x64

스파크 버전 : spark-3.2.1-bin-hadoop3.2

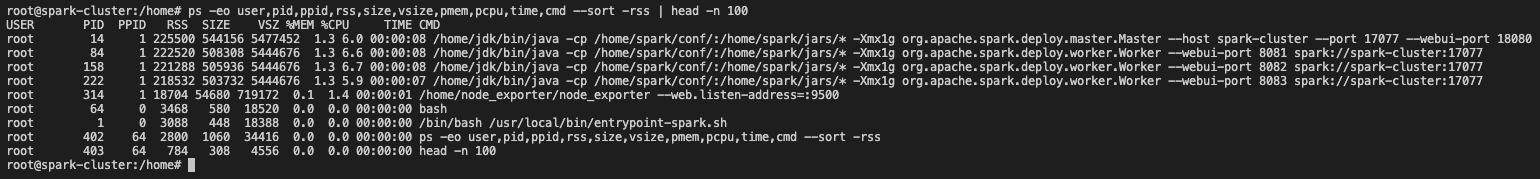

스파크 처음 실행시 상태

ps -eo user,pid,ppid,rss,size,vsize,pmem,pcpu,time,cmd --sort -rss | head -n 100

cpu 점유율이 점점 떨어진다....

cpu 점유율이 또 떨어진다

어디까지 떨어질까

아직 이르다

더

0.7 ..?

'Data Engineering > Spark' 카테고리의 다른 글

| [spark] 스파크 설치 전 jdk 설치하기 (0) | 2022.04.10 |

|---|---|

| [Spark] 애플리케이션 실행 전후 jps, cpu, memory 변화 확인하기 (0) | 2022.03.30 |

| [Spark] Apache Spark Stand-Alone 실행, 종료하는 방법 (0) | 2022.03.30 |

| [Spark] 스파크 메인 웹 UI (스파크 마스터) 포트 변경하는 방법 (0) | 2022.03.30 |

| [Spark] 스파크 스탠드얼론 워커의 코어와 메모리 설정하는 방법 (stand-alone) (0) | 2022.03.30 |